Cuộc cách mạng trí tuệ nhân tạo: Con đường tới Siêu trí tuệ (Bài dài 33353 chữ)

Lý do mà bài viết này ngốn tới ba tuần để hoàn thiện là do càng đào sâu vào vấn đề Trí tuệ nhân tạo (AI – Artificial Intelligence), tôi càng không tin nổi vào mắt mình. Rất nhanh chóng, tôi nhận ra rằng những điều đang xảy ra trong giới trí tuệ nhân tạo k

PHẦN 1 -- Cuộc cách mạng trí tuệ nhân tạo: Con đường tới Siêu trí tuệ

Tác giả: Tim Urban (waitbutwhy.com)

(Bài gốc: http://waitbutwhy.com/2015/01/artificial-intelligence-revolution-1.html)

Người dịch: https://liemaximun1208.wordpress.com/2017/03/06/cuoc-cach-mang-tri-tue-nhan-tao-con-duong-toi-sieu-tri-tue/

Lời chú của tác giả: Lý do mà bài viết này ngốn tới ba tuần để hoàn thiện là do càng đào sâu vào vấn đề Trí tuệ nhân tạo (AI – Artificial Intelligence), tôi càng không tin nổi vào mắt mình. Rất nhanh chóng, tôi nhận ra rằng những điều đang xảy ra trong giới trí tuệ nhân tạo không chỉ là một chủ đề vô cùng quan trọng, mà nó chính xác là chủ đề quan trọng nhất đối với tương lai của chúng ta. Vì vậy, tôi muốn tìm hiểu càng nhiều càng tốt về nó, và sau đó, tôi muốn chắc chắn rằng tôi viết được một bài post giải thích một cách thật cặn kẽ về tình hình hiện tại và tầm quan trọng của nó. Do vậy, cũng không có gì đáng ngạc nhiên – bài viết trở nên quá dài và tôi phải chia nó thành hai phần.

—

Chúng ta đang gần chạm tới cột mốc thay đổi có tầm vóc sánh ngang với sự kiện loài người xuất hiện trên Trái Đất – Vernor Vinge

Cảm giác khi đứng ở vị trí này ra sao nhỉ?

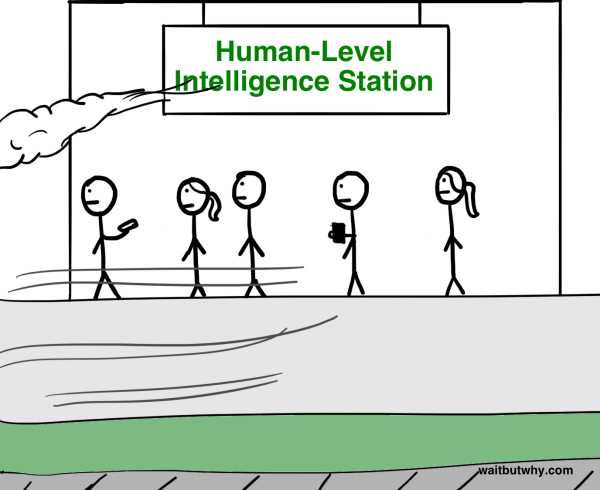

Có lẽ sẽ khá là hú hồn đấy – nhưng lúc này bạn hãy nhớ lại một chút – đứng trên đồ thị thời gian nghĩa là sao: bạn sẽ chẳng thể nhìn thấy phía bên phải mình như thế nào. Nên thực ra cảm giác thật sự là thế này kia:

Nên có lẽ bạn cảm thấy cũng khá là thường thôi…

—

Một tương lai xa vời – Đang ở ngay trước mắt

Hãy tưởng tượng: nếu như bây giờ bạn ngồi lên cỗ máy thời gian đi ngược trở lại năm 1750 – thời kì mà thế giới chẳng có mấy ý niệm về việc sử dụng năng lượng, còn liên lạc đường dài có nghĩa là bạn phải hét lên thật lớn hoặc bắn đại bác lên trời, và tất cả các phương tiện vận tải đều chạy bằng năng lượng cỏ khô. Khi bạn đã tới nơi, bạn tóm bừa lấy một anh chàng, kéo anh ta tới năm 2015, rồi dẫn anh ta đi dạo một vòng và quan sát phản ứng của anh ta với xung quanh. Có lẽ chúng ta chẳng thể tưởng tượng nổi anh ta xử lý hình ảnh của thế giới này ra sao, với những cái hộp bóng loáng lướt trên xa lộ, việc nói chuyện với những người vừa mới ở phía bên kia của đại dương trong ngày hôm nay thôi, hay xem những trận đấu thể thao đang diễn ra cách đây cả nghìn dặm, hay nghe một bản hòa tấu được trình diễn cách đây 50 năm, hay táy máy chiếc hộp ảo thuật mà anh ta có thể dùng để ghi lại một khoảnh khắc sống động hay ghi lại những chuyển động của cuộc sống, tạo ra một bản đồ với một cái chấm xanh kỳ dị di chuyển theo mỗi bước ta đi, nhìn thấy mặt một người và chuyện phiếm với họ dù họ ở đầu kia đất nước và cả tỉ thứ chuyện ma thuật quái đản nữa. Đấy là thậm chí còn chưa đến lúc bạn cho anh ta coi mạng internet hay giải thích về Trạm Vũ trụ Quốc tế, máy gia tốc hạt lớn, vũ khí hạt nhân, hay là thuyết tương đối rộng.

Trải nghiệm này, với anh ta mà nói, chẳng phải là đáng ngạc nhiên, hay là đáng kinh ngạc, thậm chí chẳng phải là sững sờ tê dại nữa – những từ đó chẳng đủ để diễn tả đâu. Anh ta có khả năng chết cứng ngay ở đó ấy chứ.

Nhưng đây mới là thứ thú vị – nếu như anh ta sau đó quay lại năm 1750 và bắt đầu thấy ghen tị vì chúng ta đem phản ứng của anh ta ra làm trò cười và quyết định rằng anh ta cũng muốn thử chuyện đó, và rồi anh ta lên cỗ máy thời gian và đi ngược lại đúng số năm đó, nhặt một người từ những năm 1500, đem người kia tới năm 1750, và dẫn anh ta đi quanh một vòng. Cái người từ năm 1500 đó sẽ thấy rất kinh ngạc trước trước kha khá thứ – nhưng khả năng anh ta chết cứng là khá nhỏ. Trải nghiệm của anh ta chẳng thể so sánh được với anh chàng kia, bởi vì dẫu cho năm 1500 rất khác so với năm 1750, sự khác biệt đó là quá ít ỏi so với sự khác biệt giữa năm 1750 và năm 2015. Anh chàng từ năm 1500 sẽ biết thêm vài thứ xoắn não về vũ trụ và vật lý, anh ta hẳn sẽ ấn tượng về việc hóa ra châu Âu lại sốt lên vì chủ nghĩa đế quốc đến vậy, và anh ta sẽ phải vẽ lại bản đồ thế giới trong đầu mình. Nhưng quan sát cuộc sống thường ngày ở năm 1750 – giao thông, liên lạc, vân vân – sẽ chẳng thể làm anh ta chết ngất được.

Không, để cho anh chàng ở năm 1750 được thỏa mãn ở mức của chúng ta khi quan sát anh ta, anh ta sẽ phải đi ngược lại xa hơn nữa – có lẽ phải đi tít tới năm 12 000 trước công nguyên, trước khi cuộc cách mạng nông nghiệp dọn đường cho những đô thị và các nền văn minh mọc lên. Nếu như có ai đó từ cái thời kỳ săn bắt hái lượm – thời kỳ mà con người cũng chẳng khác con vật là bao – nhìn thấy những đế chế năm 1750 của nhân loại với những tháp nhà thờ, những con tàu vượt biển, với khái niệm “ở trong nhà”, và những đỉnh cao tri thức vĩ đại và khám phá mà con người tích tụ được – hẳn anh chàng này sẽ chết thật đấy.

Và sau đó, nếu như, sau khi chết rồi, chính anh ta lại trở nên ghen tức và muốn làm điều tương tự. Nếu như anh ta đi ngược lại 12 000 năm nữa, tới năm 24 000 trước CN và tóm lấy một anh chàng và mang anh ta tới năm 12 000 trước CN, cho anh ta đi dạo một vòng, thì người mới này sẽ phản ứng kiểu, “Ờ rồi thì sao ý ông là gì?”. Để cho anh chàng năm 12 000 trước CN có được niềm vui đó, anh ta sẽ phải đi ngược lại khoảng 100 000 nghìn năm để kiếm một ai đó để anh ta trình diễn màn làm ra lửa và giao tiếp bằng ngôn ngữ cho người đó – lần đầu tiên.

Để cho ai đó bị mang tới tương lai và chết vì mức độ kinh ngạc mà người đó trải qua, người đó phải được mang tới trước đủ số năm mà “tiến bộ phát triển đạt ngưỡng chết”, hay là một Đơn vị Phát triển Đủ chết (Die Progress Unit – DPU) đã được tích tụ đủ. Như đã thấy, một DPU mất khoảng 100 000 năm trong thời săn bắt hái lượm, nhưng sau cách mạng nông nghiệp thì tốc độ này tăng lên, chỉ mất khoảng 12 000 năm. Thời hậu cách mạng công nghiệp thì tiến trình này nhanh hơn nhiều, đến mức một người ở năm 1750 chỉ cần đi tới khoảng vài trăm năm là đã đạt tới DPU rồi.

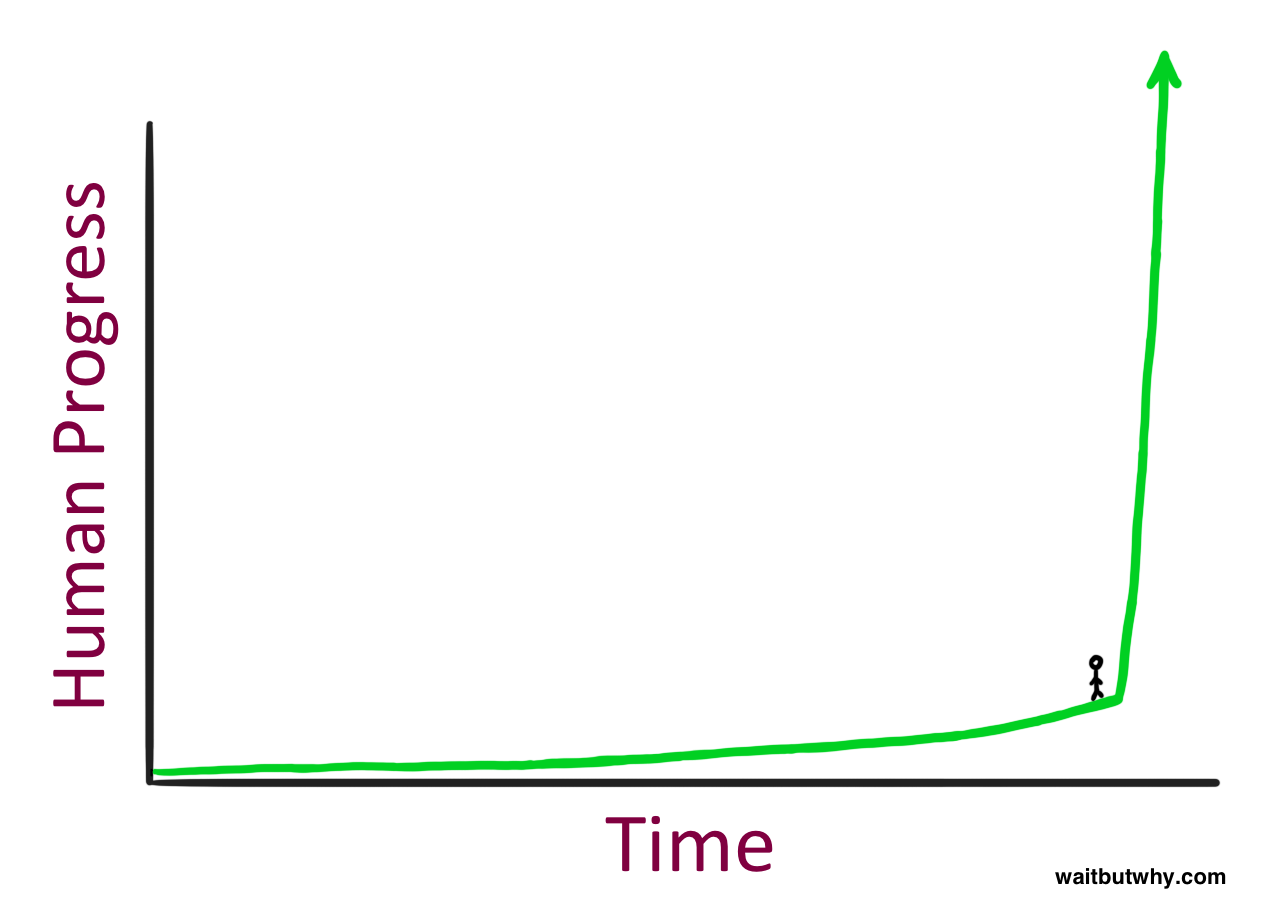

Hình mẫu này – khi tiến bộ của loài người tăng tốc dần cùng với thời gian tiến về phía trước – là điều mà nhà tương lai học Ray Kurzweil gọi là Quy luật Tăng tốc theo cấp số nhân (Law of Accelerating Returns). Điều này xảy ra do những xã hội tiến bộ ở cấp cao hơn sở hữu khả năng tiến bộ ở tốc độ lớn hơn những xã hội ở cấp thấp hơn – chính bởi vì chúng tiến bộ hơn. Loài người ở thế kỉ 19 biết nhiều hơn và có những công nghệ tốt hơn là ở thế kỉ 15, vậy nên chẳng có gì đáng ngạc nhiên là loài người tạo ra nhiều tiến bộ trong thế kỷ 19 hơn là thế kỷ 15 – xã hội loài người ở thế kỉ 15 chẳng đáng để so với xã hội loài người ở thế kỷ 19 (1).

Điều này cũng đúng ở các quy mô nhỏ hơn. Bộ phim Trở lại tương lai (Back to the Future) ra mắt vào năm 1985, và “quá khứ” trong đó là năm 1955. Trong bộ phim, khi nhân vật Michael J. Fox quay về năm 1955, cậu ta đã bị bất ngờ bởi sự mới mẻ của TV, giá của những lon soda, sự thờ ơ với những tiếng rít của đàn ghi ta điện, và sự đa dạng của tiếng lóng. Đó là một thế giới khác, đương nhiên là như vậy – nhưng nếu như bộ phim được sản xuất trong hiện tại còn quá khứ là năm 1985, thì bộ phim sẽ càng thú vị và khác biệt hơn nữa. Nhân vật sẽ bị đặt trong bối cảnh còn chưa xuất hiện máy tính cá nhân, mạng internet hay là điện thoại di động – cậu Marty McFly của ngày nay, một thiếu niên sinh vào cuối thập niên 90, sẽ càng sửng sốt hơn ở năm 1985 so với cậu McFly trong bộ phim đối với năm 1955.

Lý do cũng giống như khi chúng ta bàn khi trước – Luật Tăng tốc theo cấp số nhân. Tốc độ tiến bộ giữa năm 1985 và 2015 cao hơn nhiều so với tốc độ giữa năm 1955 và 1985 – bởi vì cặp đầu nằm trong thời kì tiến bộ hơn – nên nhiều thay đổi đã xảy ra hơn trong 30 năm gần đây hơn là 30 năm trước đó.

Vậy là – tiến bộ ngày càng trở nên tầm vóc hơn và diễn ra mỗi lúc một nhanh hơn. Điều này gợi ra một viễn cảnh hết sức hoành tráng, có phải không?

Kurzweil chỉ ra rằng bước tiến của toàn thế kỷ 20 chỉ mất có 20 năm để hoàn thành với tốc độ phát triển ở năm 2000 – tức là, cho tới năm 2000, tốc độ phát triển đã nhanh hơn gấp 5 lần so với tốc độ phát triển trung bình của toàn thế kỷ 20. Ông tin rằng một khối lượng phát triển tương đương với khối lượng của toàn thế kỉ 20 đã diễn ra trong khoảng thời gian từ năm 2000 tới năm 2014 và rằng một khối lượng tương đương sẽ chạm mốc vào năm 2021, trong vòng vỏn vẹn 7 năm. Một vài thập niên nữa, ông cho rằng khối lượng đó sẽ được lặp lại tới vài lần trong một năm, và sau đó thì có lẽ chỉ còn vài lần trong một tháng. Tựu chung lại, do Luật Tăng tốc theo cấp số nhân, Kurzweil tin rằng thế kỷ 21 sẽ đạt được khối lượng tiến bộ gấp 1000 lần khối lượng của thế kỷ 20. (2)

Nếu như Kurzweil và những người ủng hộ ông đoán đúng, thì có lẽ chúng ta sẽ kinh ngạc với hình ảnh của năm 2030 y hệt như anh chàng 1750 đi tới năm 2015 vậy – tức nghĩa là mốc DPU tiếp theo sẽ chỉ tốn khoảng vài thập kỷ – và thế giới ở năm 2050 sẽ khác biệt kinh khủng so với thế giới hiện nay đến mức ta chẳng thể nhận ra nổi.

Đó không phải là khoa học viễn tưởng. Đó là điều mà nhiều nhà khoa học thông minh và hiểu biết hơn tôi và bạn rất nhiều tin tưởng chắc chắn – và nếu như nhìn lại lịch sử, đó là điều mà chúng ta có thể dự đoán được bằng logic.

Vậy thì tại sao, khi bạn nghe tôi nhắc tới câu “35 năm nữa thế giới sẽ trở nên chẳng thể nhận ra nổi,” có phải bạn thoáng nghĩ rằng “Ngầu thiệt, nhưng chắc là không đâu”? Ba lý do chúng ta hết sức hoài nghi về những dự đoán lạ thường về tương lai là:

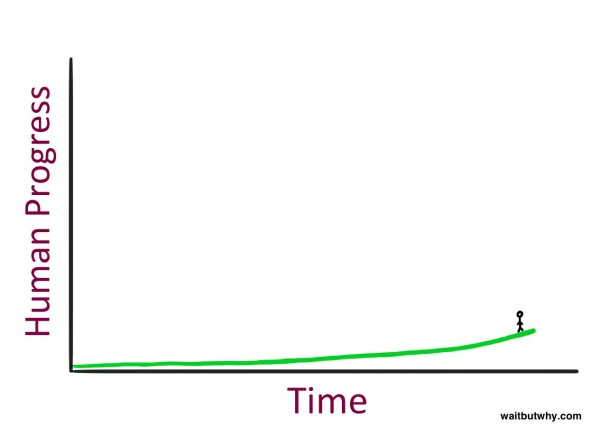

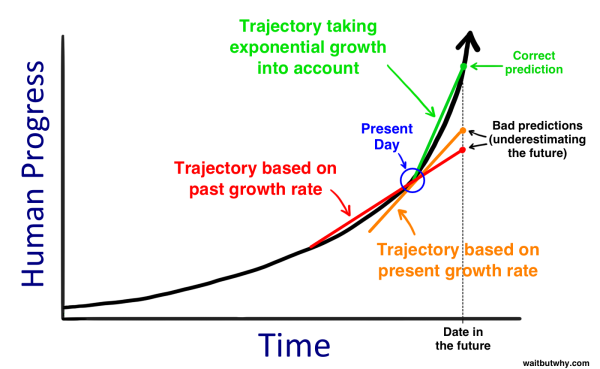

1, Khi bàn về lịch sử, chúng ta có xu hướng nghĩ theo tuyến tính. Khi chúng ta tưởng tượng về những phát triển trong 30 năm nữa, chúng ta liên tưởng tới mức độ phát triển của 30 năm trước để hình dung ra điều đó. Khi chúng ta nghĩ về mức độ thay đổi của thế giới trong thế kỷ 21, chúng ta gán cho năm 2000 cái mốc bắt đầu và cộng dồn vào mức phát triển của thế kỉ 20. Đây chính là lỗi mà anh chàng năm 1750 đã mắc phải khi túm lấy một người từ năm 1500 và hy vọng sẽ làm anh này kinh ngạc ở mức anh ta đã bị khi tiến lên trước cùng một khoảng thời gian. Chúng ta thường cảm tính suy nghĩ theo tuyến tính, trong khi đáng lẽ phải nghĩ theo cấp số nhân. Nếu có ai đó thông minh hơn, họ hẳn sẽ không đoán định tiến trình trong 30 năm sau bằng cách nhìn lại 30 năm trước, mà sẽ nhìn vào tốc độ phát triển hiện tại và dựa vào đó mà suy đoán. Họ sẽ chính xác hơn một chút, nhưng vẫn còn cách khá xa sự thật. Để dự đoán chính xác, bạn cần phải tưởng tượng mọi thứ ở tốc độ nhanh hơn rất nhiều so với tốc độ hiện thời.

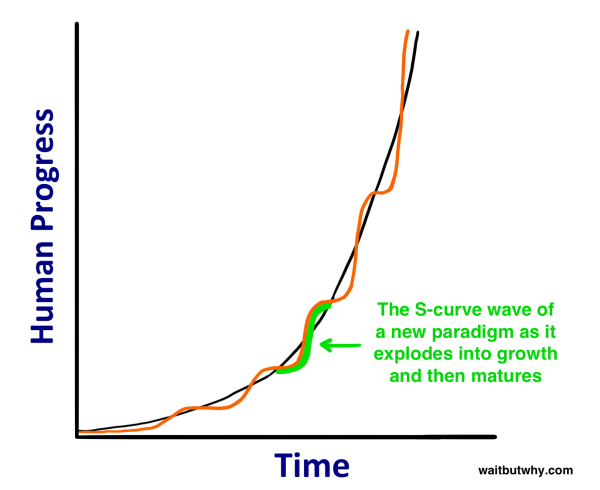

2) Quỹ đạo của thời kỳ ngay sát hiện tại đem lại một cái nhìn lệch lạc. Đầu tiên là, ngay cả một đường hàm mũ rất dốc cũng có vẻ tuyến tính nếu như bạn chỉ nhìn vào một đoạn rất nhỏ của nó, giống như khi bạn nhìn vào một đoạn nhỏ trong một đường tròn khổng lồ, đường này sẽ giống như một đoạn thẳng vậy. Hai là, tăng trưởng theo hàm mũ không hẳn lúc nào cũng láng mượt và đồng nhất. Kurzweil giải thích rằng tăng trưởng diễn ra theo các “đường chữ S”:

Một đoạn S được tạo ra bởi những làn sóng tiến bộ khi một thức dạng mới trỗi dậy trên toàn cầu. Đường cong này trải qua ba thời kỳ:

- Tăng trưởng chậm (giai đoạn đầu của tăng trưởng hàm mũ)

- Tăng trưởng nhanh (giai đoạn sau, giai đoạn bùng nổ của tăng trưởng hàm mũ)

- Giảm tốc dần khi thức dạng đạt tới mức trưởng thành. (3)

Nếu như bạn chỉ nhìn vào thời kì ngay sát trước, phần chữ S mà bạn nhìn vào sẽ làm cho bạn có một nhận thức lệch lạc về tốc độ phát triển. Mẩu thời gian giữa năm 1995 và 2007 đã chứng kiến sự bùng nổ của internet, sự xuất hiện của Microsoft, Google, và Facebook trong nhận thức của công chúng, khai sinh cho mạng xã hội, và sự xuất hiện của điện thoại di động và sau đó là điện thoại thông minh. Đó là thời kỳ 2: thời kì bùng nổ của đường S. Nhưng từ 2008 tới 2015 thì lại yên ắng hơn, ít nhất là trong mặt trận công nghệ. Một người khi nghĩ tới tương lai trong hiện tại sẽ có thể xem xét những năm gần nhất đó và đánh giá thấp tốc độ tăng trưởng hiện tại, nhưng như thế là thiếu cái nhìn toàn cảnh. Thực chất, một thời kỳ 2 bùng nổ khác có thể đang được thai nghén ngay từ lúc này.

3) Kinh nghiệm của chính chúng ta biến chúng ta thành những lão già cứng đầu khi nói tới tương lai. Chúng ta hình thành những ý niệm về thế giới bằng những trải nghiệm cá nhân, và những trải nghiệm đó đã khắc sâu rằng tốc độ phát triển trong thời kỳ gần đây chính là cái cách mà “mọi thứ diễn ra”. Chúng ta đồng thời cũng bị giới hạn bởi sức tưởng tượng của bản thân, dựa vào kinh nghiệm cá nhân để vẽ ra những dự đoán về tương lai – nhưng thường thì, những điều chúng ta biết không hẳn cho chúng ta những thước đo chính xác về tương lai. Khi chúng ta nghe thấy một dự báo tương lai đi ngược lại những ý niệm dựa trên kinh nghiệm về mọi thứ diễn ra như thế nào, bản năng mách bảo chúng ta rằng dự báo đó hẳn rất ngây thơ. Nếu như tôi nói với bạn, chỉ ngay trong bài post này thôi, rằng bạn sẽ sống tới 150, 250 tuổi, hay thậm chí sẽ bất tử, bản năng của bạn sẽ là, “Ngớ ngấn thật – lịch sử cho tôi biết rằng chẳng có ai là sống mãi được cả.” Và đúng vậy, rõ ràng chẳng có ai trong quá khứ mà chưa chết cả. Nhưng chưa từng có ai đi máy bay cho tới khi máy bay được phát minh ra đó thôi.

Vậy là khi khônggggg có thể sẽ là cảm giác theo bạn trong suốt quá trình đọc bài viết này, nó rất có thể sẽ sai. Sự thật là, nếu như chúng ta đi theo đúng logic và chờ đợi các khuôn mẫu lịch sử được lặp lại, chúng ta phải kết luận rằng rất nhiều, cực kì, vô cùng nhiều điều sẽ thay đổi trong những thập kỷ tới đây, nhiều hơn những gì bản năng mách bảo chúng ta. Logic chỉ ra rằng nếu như một loài tiến bộ nhất trên một hành tinh cứ tiếp tục tạo ra những bước nhảy vọt ngày càng lớn hơn với tốc độ ngày càng cao hơn, ở một thời điểm nào đó, loài này sẽ nhảy một bước lớn tới mức sẽ làm thay đổi toàn bộ cuộc sống như họ từng biết và nhận thức họ có về thế nào là một con người – giống như là tiến hóa đã nhảy vọt những bước lớn hướng về trí tuệ cho đến khi nó nhảy một bước khổng lồ và tạo ra con người và thay đổi hoàn toàn cái gọi là sự sống của bất kỳ loài nào trên hành tinh này. Và nếu như bạn dành thời gian theo dõi những điều đang diễn ra trong khoa học và công nghệ, bạn sẽ nhận ra kha khá những dấu hiệu lặng lẽ ám chỉ rằng cuộc sống mà chúng ta từng biết sẽ không thể nào thoát khỏi ảnh hưởng của bước nhảy tiếp theo.

—

Con đường tới Siêu trí tuệ

AI là gì?

Nếu như bạn giống như tôi, tức là bạn đã từng nghĩ rằng trí tuệ nhân tạo (AI) là một khái niệm khoa học viễn tưởng ngốc nghếch, nhưng dạo gần đây bắt đầu nghe nó được nhắc tới một cách rất nghiêm túc bởi những người đáng tin cậy, và bạn chẳng hiểu gì mấy về chuyện này.

Có ba lý do khiến mọi người khá bối rối khi nghe về AI:

- Chúng ta liên tưởng AI tới các bộ phim. Chiến tranh giữa các vì sao, Kẻ hủy diệt, 2001: Bản Odyssey Vũ trụ. Nhà Jetsons. Và tất cả đều là tưởng tượng, kể cả cáh nhân vật robot. Nên chúng ta cảm thấy AI có vẻ chỉ là viễn tượng thôi.

- AI là một chủ đề rất rộng. Nó bao gồm từ máy tính trong điện thoại của bạn tới xe tự lái hay điều gì đó trong tương lai sẽ làm thay đổi thế giới một cách khủng khiếp. AI bao trùm tất cả những thứ đó, vậy nên khá dễ gây nhầm lẫn.

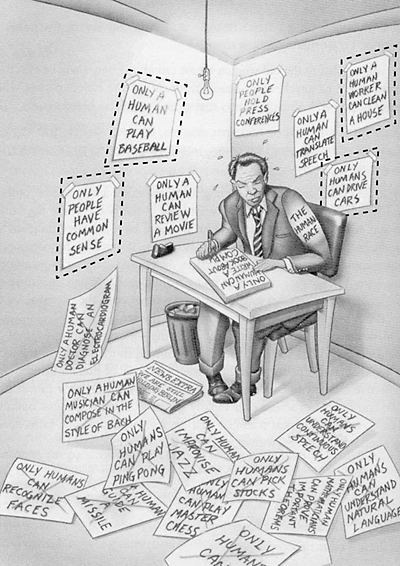

- Chúng ta thường xuyên sử dụng AI trong cuộc sống hàng ngày nhưng thường không biết đó chính là AI. John McCarthy, cha đẻ của thuật ngữ “Trí tuệ nhân tạo” (AI) vào năm 1956, kêu ca rằng “cứ đến lúc nó hoạt động được thì chẳng ai gọi nó là AI nữa.” (4) Do hiệu ứng này, AI nghe giống như là một dự đoán huyền bí về tương lai hơn là một thực tế. Cùng lúc đó, nghe nó như thể là một khái niệm huyễn hoặc trong quá khứ chưa bao giờ tạo ra được thành quả vậy. Ray Kurzweil nói rằng nhiều người kết luận rằng AI đã thất bại từ những năm 80, và so sánh điều này như thể “khăng khăng rằng internet dã chết trong cái thời bùng nổ tên miền vào đầu những năm 2000.” (5)

Giờ chúng ta cần làm rõ vấn đề một chút. Đầu tiên là, hãy ngừng nghĩ tới robot. Robot chỉ là cái vỏ chứa cho AI, đôi khi có dạng mô phỏng con người, đôi khi không – nhưng AI chính là bộ máy chứa bên trong robot. AI là bộ não, còn robot là thân thể của nó – nếu như nó có thân thể. Ví dụ như, phần mềm và dữ liệu của Siri chính là AI, giọng phụ nữ mà chúng ta nghe thấy là dạng nhân cách hóa của AI đó, và ở đây chẳng có robot nào cả.

Thứ hai là, bạn có thể đã từng nghe qua thuật ngữ “dị biệt” hay “dị biệt công nghệ” (technological singularity). Thuật ngữ này được sử dụng trong toán học để miêu tả một trường hợp tiệm cận mà tất cả những định luật thông thường không còn đúng nữa. Nó được sử dụng trong vật lý để diễn tả một hiện tượng như là một lỗ đen đặc quánh và nhỏ vô cùng hay là điểm mà tất cả mọi thứ cô đặc lại ngay trước vụ nổ Big Bang. Nhắc lại, đó là những tình huống mà những quy luật thông thường không còn đúng nữa. Vào năm 1993, Vernor Vinge viết một bài luận nổi tiếng, trong đó ông sử dụng thuật ngữ này để gọi một thời khắc trong tương lai, khi trí thông minh công nghệ vượt quá trí tuệ của chính chúng ta – thời khắc mà, đối với ông, cuộc sống như ta từng biết sẽ thay đổi vĩnh viễn và những quy luật thông thường bị phá vỡ. Ray Kurzweil có can thiệp vào một chút bằng cách định nghĩa điểm dị biệt là khi Quy luật tăng tốc theo hàm mũ đạt tới tốc độ quá ngưỡng, và sau đó chúng ta sẽ sống trong một thế giới hoàn toàn mới mẻ. Tôi nhận thấy rằng nhiều nhà nghiên cứu AI hiện nay không còn sử dụng thuật ngữ này, và nó cũng khá dễ nhầm lẫn, nên trong bài viết này tôi sẽ không sử dụng nó nhiều (dù vậy, ý tưởng đằng sau nó vẫn là trọng tâm trong suốt toàn bài).

Cuối cùng là, trong khi có rất nhiều loại hay dạng của AI vì AI là một khái niệm rất rộng, cách phân loại sâu sắc nhất mà chúng ta cần quan tâm là dựa vào năng lực của AI. Có ba loại năng lực AI chính:

Năng lực AI 1) Trí tuệ nhân tạo hẹp (Artificial Narrow Intelligence – ANI): Đôi khi được gọi với cái tên AI yếu, ANI là loại AI chỉ tập trung vào một lĩnh vực. Có AI đánh thắng nhà vô địch thế giới về cờ vua, nhưng đó là điều duy nhất nó có thể làm được. Nếu như bạn đặt câu hỏi cho nó về việc làm thế nào để dự trữ dữ liệu trong ổ cứng tốt hơn, nó sẽ chẳng thể đáp lại được.

Năng lực AI 2) Trí tuệ nhân tạo rộng (Artificial General Intelligence – AGI): Đôi khi được gọi là AI mạnh, hay AI cấp độ người, AGI là một bộ máy thông minh ở cấp trung bình của con người – một cỗ máy có thể thực hiện bất kỳ nhiệm vụ trí tuệ nào mà con người có thể xử lý được. Tạo ra AGI là một nhiệm vụ khó khăn hơn nhiều so với ANI, và chúng ta vẫn chưa thể làm được điều này. Giáo sư Linda Gottfredson mô tả trí tuệ là “một năng lực tinh thần rất chung bao gồm nhưng không hạn chế trong khả năng lý luận, lập kế hoạch, giải quyết vấn đề, tư duy trừu tượng, hiểu được những ý tưởng phức tạp, học hỏi nhanh và học hỏi từ kinh nghiệm.” AGI sẽ có thể làm được tất cả những điều này một cách dễ dàng y hệt như bạn vậy.

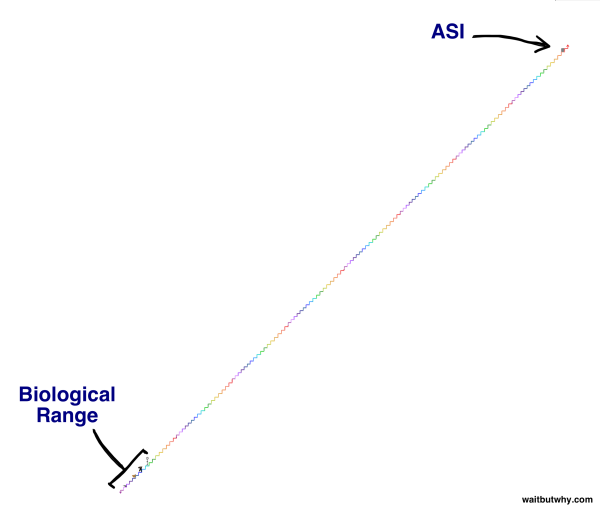

Năng lực AI 3) Siêu trí tuệ nhân tạo (Artificial Superintelligence – ASI): Nhà triết học và trí tuệ nhân tạo học Oxford hàng đầu, Nick Bostrom, định nghĩa siêu trí tuệ là “một trí tuệ thông minh hơn tất cả những bộ não uyên bác nhất trên tất cả mọi lĩnh vực, bao gồm cả sáng tạo khoa học, trí khôn thông thường và năng lực xã hội.” ASI dao động từ một cỗ máy chỉ thông minh hơn con người một chút cho tới một cỗ máy thông minh gấp hàng triệu tỷ lần một người bình thường. ASI là lý do cho sự cuốn hút của chủ đề về AI và cũng là lý do những cụm từ “bất tử” và “tuyệt chủng” sẽ cùng xuất hiện khá nhiều lần trong bài viết này.

Hiện nay, con người đã chinh phục được cấp độ thấp nhất của năng lực AI –

ANI – theo rất nhiều cách khác nhau, và chúng phổ biến ở khắp nơi. Cuộc cách mạng AI là con đường đi từ ANI, cho tới AGI, rồi tới ASI – một lộ trình mà chúng ta có thể sống sót hoặc không, nhưng dù là thế nào đi nữa, cũng sẽ thay đổi tất cả mọi thứ.

Giờ hãy quan sát kỹ lưỡng hơn con đường này dưới con mắt của những nhà tư tưởng hàng đầu trong lĩnh vực này, cùng với lý do tại sao cuộc cách mạng này sẽ diễn ra sớm hơn rất nhiều so với những gì bạn nghĩ:

Chúng ta đang ở đây – Một thế giới phụ thuộc vào ANI

ANI là một cỗ máy có trí tuệ tương đương hay vượt quá trí tuệ và độ hiệu quả của con người trong một lĩnh vực cụ thể. Một số ví dụ như là:

- Xe ô tô chứa đầy những hệ thống ANI, từ bộ não máy tính đảm nhiệm chức năng vận hành phanh phản khóa (anti-block brakes) cho tới máy đo đồng hồ xăng. Xe tự lái của Google, mà hiện nay đang được thử nghiệm, sẽ chứa những hệ thống ANI tiên tiến dùng để nhận biết và phản ứng lại với môi trường xung quanh.

- Điện thoại của bạn là một nhà máy ANI thu nhỏ. Khi bạn điều hướng theo ứng dụng bản đồ, nhận được gợi ý nghe nhạc theo sở thích cá nhân trên Pandora, xem dự báo thời tiết, nói chuyện với Siri, hay là cả tỉ thứ công việc thường nhật khác, bạn đang sử dụng ANI.

- Bộ lọc thư rác trong thư điện tử là một loại ANI điển hình – nó được tải đầy trí tuệ về việc làm thế nào để nhận ra đâu là thư rác, và rồi nó học hỏi và tự điều chỉnh theo chính bạn khi nó thu thập được những kinh nghiệm về những thói quen của bạn. Nest Thermostat cũng làm chính như vậy khi nó nhận ra những thói quen điển hình của bạn và điều chỉnh phản ứng theo đó.

- Bạn nhớ cảm giác gai người khi bạn tìm một sản phẩm trên Amazon và rồi bạn thấy chính sản phẩm đó xuất hiện trong mục “gợi ý cho bạn” ở một trang web khác, hay khi Facebook làm thế nào đó biết được ai nên được kết bạn với bạn chứ? Đó là một mạng lưới các hệ thống ANI, cùng làm việc để thông báo với nhau về bạn là ai và bạn thích gì và rồi dùng thông tin đó để quyết định trình ra trước mắt bạn thứ gì. Điều tương tự với mục “Những người mua món này cũng sẽ mua…” của Amazon – đó là một hệ thống ANI với nhiệm vụ là thu thập thông tin từ hành vi của hàng triệu người mua hàng và tổng hợp những thông tin đó để “upsell” bạn một cách thông minh và khiến bạn mua nhiều hơn nữa.

- Google Translate là một hệ thống ANI cổ điển điển hình khác – rất ấn tượng trong một nhiệm vụ cụ thể. Nhận diện giọng nói cũng tương tự như thế, và có hàng tá các ứng dụng sử dụng hai ANI đó thành một đội, giúp bạn có thể nói một câu bằng một ngôn ngữ rồi máy tính sẽ nói lại câu đó trong một ngôn ngữ khác.

- Khi máy bay hạ cánh, không người nào quyết định nó sẽ đỗ ở cửa số mấy. Cũng không phải con người quyết định giá vé máy bay.

- Những nhà vô địch thế giới trong các bộ môn Checkers, Scrablle, Backgammon và Othello giờ đều là ANI hết.

- Cỗ máy tìm kiếm Google là một bộ não ANI khổng lồ với những phương pháp hết sức phức tạp để xếp hạng các trang web và quyết định trình ra cho bạn xem cái nào. Newsfeed của Facebook cũng vậy.

- Và đó chỉ là những ví dụ trong giới tiêu dùng. Những hệ thống ANI phức tạp được sử dụng rộng rãi trong những phân ngành hay những ngành công nghiệp như quân sự, sản xuất, và tài chính (những nhà giao dịch AI sử dụng thuật toán tần suất cao can thiệp vào hơn nửa những giao dịch chứng khoán tại thị trường Mỹ (6) ), và trong các hệ thống chuyên môn như là giúp đỡ bác sĩ trong việc chuẩn đoán bệnh và, nổi tiếng nhất là Watson của IBM, cỗ máy chứa đủ thông tin và hiểu ngôn ngữ bị bóp méo đủ tốt để nắm chắc phần thắng ngay cả trước những người chơi Jeopardy! thông thái nhất.

Các hệ thống ANI như hiện nay không hẳn là đáng sợ lắm. Tệ nhất chỉ là khi một ANI gặp trục trặc tạo nên một thảm họa riêng biệt như là phá hỏng hệ thống điện, làm cho một nhà máy điện hạt nhân gặp phải một sự cố tai hại, hay gây ra một thảm họa trên thị trường tài chính (như vụ Flash Crash năm 2010 và làm cho thị trường chứng khoán tạm thời tụt dốc không phanh, mang theo khoảng 1 nghìn tỷ đô la giá trị thị trường, và chỉ một phần trong đó được phục hồi khi sự cố được khắc phục).

Nhưng trong khi ANI không có khả năng tạo nên các mối đe dọa diệt chủng, chúng ta nên nhìn nhận hệ sinh thái đang ngày càng bành trướng và tăng dần về độ phức tạp của những ANI tương đối vô hại là một chỉ dấu cho cơn lốc sẽ thay đổi toàn bộ thế giới sắp quét qua. Mỗi đổi mới về ANI sẽ lặng lẽ đặt thêm một viên gạch trên con đường đi tới AGI và ASI. Hay như Aaron Saenz nhìn nhận, các hệ thống ANI của chúng ta “giống như các amino acid trong bát súp nguyên thủy của Trái đất trong thời kỳ đầu” – những nền tảng còn bất động của sự sống mà, trong một ngày không báo trước, bất ngờ sống dậy.

Con đường từ ANI tới AGI

Tại sao lại khó khăn đến thế

Chẳng có gì khiến bạn trầm trồ trí tuệ của loài người bằng lúc bạn biết được rằng tái tạo được mức độ thông minh đó cho một cỗ máy là một công việc khó khăn đến thế nào. Xây dựng những tòa nhà cao tầng, đưa con người vào vũ trụ, tìm hiểu những chi tiết về vụ nổ Big Bang – tất cả đều dễ dàng hơn nhiều so với việc hiểu chính bộ não của chính chúng ta hay làm thế nào để tạo ra một thứ gì ngầu như thế. Như hiện nay, bộ não người chính là thứ phức tạp nhất trong toàn vũ trụ.

Điều thú vị là phần khó khăn nhất trong nỗ lực xây dựng AGI (một máy tính thông minh như con người nói chung, chứ không phải chỉ ở trong một lĩnh vực) lại không phải như bạn nghĩ. Xây dựng một cỗ máy có thể nhân hai số có mười chữ số trong một phần nghìn giây – dễ như ăn kẹo. Dựng một cái nhìn vào con chó và có khả năng trả lời đó là con chó hay con mèo – phức tạp lắm rồi đây. Tạo ra một AI đánh bại bất kỳ người nào trong môn cờ vua? Có rồi. Tạo ra một cái đọc một đoạn văn trong một cuốn sách tranh dành cho trẻ 6 tuổi và không chỉ nhận diện ra những từ ngữ mà còn hiểu được ý nghĩa của chúng? Google đang dành hàng tỷ đô để làm điều đó. Những điều đau đầu như tính toán, chiến lược thị trường chứng khoán hay dịch ngôn ngữ – là những điều đơn giản đến mức kinh ngạc đối với máy tính, trong khi những thứ đơn giản – như hình ảnh, chuyển động, di động và nhận thức – lại cực kỳ khó khăn với chúng. Hay là, như nhà khoa học máy tính Donald Knuth giải thích, “AI hiện giờ đã thành công trong việc làm gần như tất cả những điều cần tới việc “suy nghĩ”, nhưng lại thất bại trong việc làm những điều mà con người hay động vật làm mà không cần tới suy nghĩ.” (7)

Một điều mà bạn có lẽ nhanh chóng nhận ra khi bạn nghĩ về điều này, đó là những điều tưởng chừng như đơn giản với chúng ta lại thực ra vô cùng phức tạp đến mức không thể tin nổi, và chúng chỉ có vẻ đơn giản như vậy vì những kỹ năng đó đã được tối ưu hóa trong chúng ta (và nhiều loài vật khác) bằng hàng trăm triệu năm tiến hóa. Khi bạn đưa tay ra với lấy một vật, các cơ, gân và xương trên vai, khuỷu tay và cổ tay ngay lập tức thao tác một loạt các chuyển động vật lý đồng bộ hóa với đôi mắt, cho phép bạn chuyển động tay trên một đường thẳng trong không gian ba chiều. Đối với bạn, điều này chẳng tốn nhiều nỗ lực gì cho cam bởi vì bạn đã có một phần mềm được hoàn thiện hết mức trong não nhằm thực hiện điều này. Đây cũng là lý do tại sao không phải những phần mềm gây hại là ngu ngốc khi chúng không nhận ra được những từ biến dạng mà bạn phải điền vào khi thiết lập một tài khoản mới trên một website – mà chính là bộ não của bạn quá đáng kinh ngạc khi có khả năng đó.

Mặt khác, nhân các số lớn hay chơi cờ là những hoạt động mới mẻ đối với các sinh vật và chúng ta chưa có thời gian để tiến hóa tới mức làm chúng một cách thuần thục được, nên một cỗ máy không cần phải quá tốn công sức để vượt mặt chúng ta. Hãy nghĩ về điều này – bạn muốn làm gì hơn, xây dựng một chương trình có thể nhân các số lớn hay là một chương trình có thể hiểu được bản chất của chữ B đủ để có thể nhận ra chữ B với bất kỳ phông chữ hay chữ viết tay khó đoán nào mà nó vẫn nhận ra đó là chữ B không?

Một ví dụ vui – khi bạn nhìn vào hình này, cả bạn và máy tính đều có thể nhận ra nó là một hình chữ nhật với những màu đậm nhạt xen kẽ nhau:

Vậy là hòa nhé. Nhưng nếu như bạn bỏ phần màu đen đi và để lộ toàn bộ bức hình…

Bạn chẳng khó khăn gì cũng có thể mô tả những hình xi lanh đục và mờ, các thanh và các góc 3 chiều, nhưng máy tính sẽ thất bại toàn tập. Nó sẽ mô tả những gì nó thấy – một loạt các hình 2 chiều nằm trong các sắc độ khác – mà thực tế đúng là như vậy. Não bạn đã xử lý cực kì tinh vi để có thể nhận dạng được độ sâu được ngầm chỉ, sự phối màu, và nguồn sáng mà bức tranh muốn thể hiện (8). Và nhìn vào hình dưới đây, máy tính sẽ chỉ nhìn thấy một màn trắng, đen và xám hỗn độn, trong khi bạn có thể dễ dàng nhận ra đây là cái gì – chính là một bức ảnh một cục đá ba chiều màu đen tuyền:

Credit: Matthew Lloyd

Và tất cả những điều mà chúng ta vừa nói tới mới chỉ là ghi nhận thông tin tĩnh và xử lý nó. Để đạt được mức thông minh như con người, máy tính sẽ phải hiểu được những thứ như là sự khác biệt giữa các biểu cảm gương mặt khác nhau, giữa trạng thái vui lòng, nhẹ nhõm, vừa lòng, thỏa mãn hay vui mừng, và tại sao phim Braveheart thật tuyệt trong khi bộ The Patriot thì dở tệ.

Mệt thật đấy.

Thế thì làm sao chúng ta có thể đạt được điều đó?

Chìa khóa đầu tiên để tạo ra AGI: Tăng sức mạnh tính toán

Một điều cần thiết không thể tranh cãi để tạo ra được AGI là nâng cấp được sức mạnh của phần cứng. Nếu như một hệ thống AI muốn được thông minh như bộ não người, nó cần phải đạt được mức khả năng tính toán nền của bộ não.

Một cách để thể hiện khả năng này chính là số đơn vị phép tính trên giây (total calculations per second – cps) mà bộ não có thể thực hiện, và bạn có thể lấy được số này bằng cách tìm ra được lượng cps tối đa mà mỗi phần của não có khả năng thực hiện rồi cộng lại với nhau.

Ray Kurzweil tìm ra một lối tắt bằng cách lấy tính toán về cps của một nhà khoa học chuyên nghiệp nào đó cho một phần của não và tính khối lượng phần đó trên tổng khối lượng bộ não rồi nhân tỷ lệ lên để ước lượng năng lực tổng. Nghe có vẻ chả đáng tin mấy, nhưng ông ta đã lặp lại vụ này vài lần với các kết quả tính toán cho từng khu khác nhau trong não, và lúc nào cũng ra được số liệu na ná nhau, khoảng 10^16, hay là 10 quadrillion cps.

Hiện nay, siêu máy tính nhanh nhất thế giới, chiếc Thiên Hà-2 của Trung quốc, thực ra đã vượt qua con số đó, với khoảng 34 quad cps. Nhưng cái máy này cũng rất khốn nạn, vì nó chiếm tới 720 mét vuông, dùng tới 24 megawatt (trong khi não người dùng có 20 watt để chạy), và tốn tới 390 triệu đô để thiết lập. Không hẳn hữu dụng để áp dụng rộng rãi hay trong công nghiệp hay thương mại gì hết.

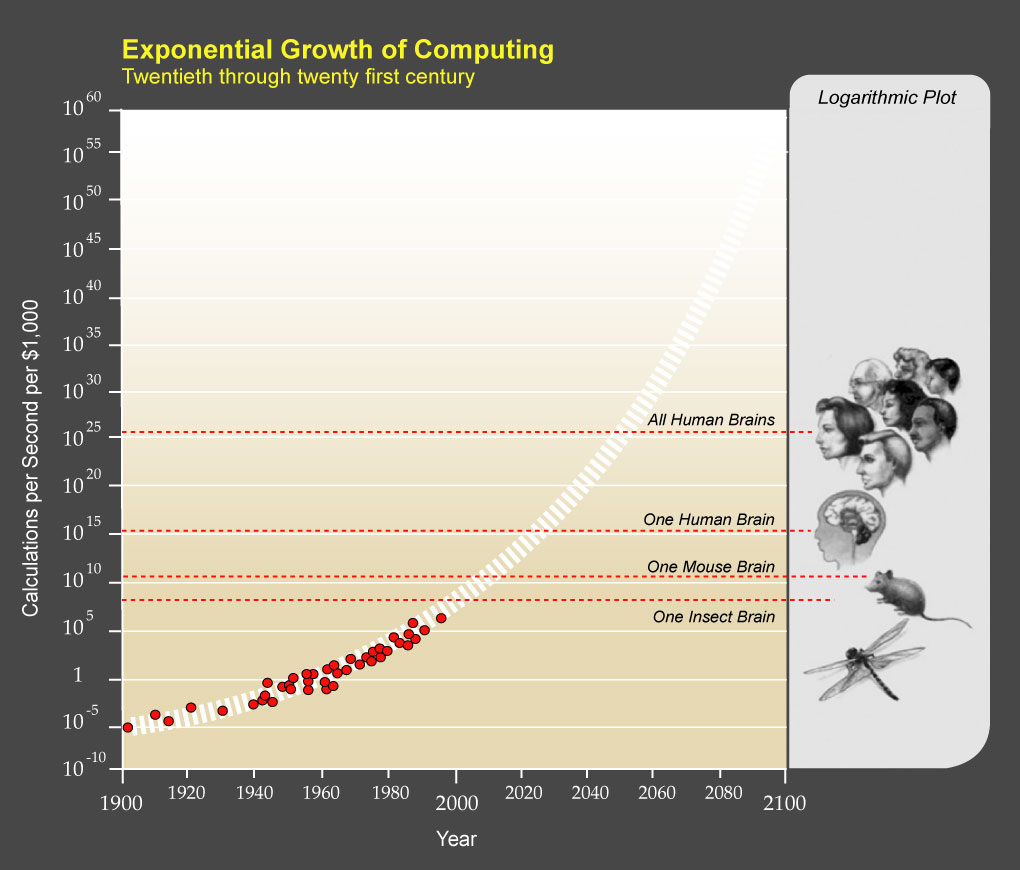

Kurweil cho rằng chúng ta nên nghĩ về tình trạng của máy tính bằng việc xem xét với 1000 đô thì có thể mua được bao nhiêu cps. Khi con số đó đạt gần tới mốc của con người – 10 quad cps – tức là AGI hoàn toàn có thể trở thành sự thật.

Định luật Moore là một định luật được kiểm chứng lịch sử là hiệu quả, nói rằng tổng năng lực tính toán tối đa của toàn thế giới sẽ nhân đôi sau mỗi hai năm, tức là sự tiến bộ của phần cứng máy tính, giống như sự tiến bộ chung của nhân loại trong lịch sử, sẽ tăng theo hàm mũ. Áp dụng với số liệu của Kurzweil về cps/1000 đô, chúng ta đang nằm ở mốc 10 nghìn tỷ cps/1000 đô, đúng với tốc độ được mô tả trên quỹ đạo được dự đoán trên biểu đồ sau: (9)

Vậy là những chiếc máy tính giá 1000 đô hiện nay đã vượt qua ngưỡng bộ não chuột và đang ở khoảng một phần nghìn bộ não người. Nghe thì chẳng thấm vào đâu, cho tới khi bạn nhớ ra là chúng ta chỉ đạt mức một phần nghìn tỉ vào năm 1985, rồi thì một phần tỷ năm 1995, và rồi một phần triệu vào năm 2005. Đạt được mốc một phần nghìn vào năm 2015 đặt chúng ta vào đúng quỹ đạo để tiến tới việc sở hữu một cỗ máy tính với giá phải chăng và năng lực tính toán xấp xỉ ngưỡng loài người.

Vậy là về mặt phần cứng, nguồn lực cơ bản cho AGI đã được đáp ứng về mặt công nghệ hiện nay, tại Trung Quốc, và chúng ta sẽ sớm có được phần cứng đạt mức AGI với giá phải chăng trong vòng 10 năm nữa. Nhưng năng lực tính toán thô không làm cho một chiếc máy tính trở nên thông minh – câu hỏi tiếp theo là, làm thế nào chúng ta đưa được trí thông minh của loài người vào cỗ máy đó?

Chìa khóa thứ hai để tạo ra AGI: Làm nó trở nên thông minh

Đây mới là phần khấp khuỷu. Sự thật là, chẳng ai thật sự biết làm thế nào để cỗ máy thông minh lên được – chúng ta vẫn còn đang tranh luận làm thế nào để máy tính có thể thông minh như con người và biết con chó là gì và một chữ B xiên vẹo hay một bộ phim nhạt toẹt là như thế nào. Nhưng có kha khá những chiến lược kì dị ngoài kia, và đến một lúc nào đó, một trong số chúng sẽ thành ra có hiệu quả. Dưới đây là ba loại chiến lược phổ biến nhất mà tôi đã gặp:

1) Sao chép bộ não

Đó là khi những nhà khoa học phát rồ lên vì đứa nhóc ngồi cạnh họ trong lớp quá thông minh và lại luôn được điểm quá cao ở các bài kiểm tra, trong khi họ có gắng học chăm chỉ thế nào đi nữa thì cũng chẳng thể lại nổi, và thế là cuối cùng họ quyết định: “Thôi kệ giờ cứ chép bài đứa kia cho nhanh.” Nghe có lý đó chứ – chúng ta đang mắc kẹt khi phải tạo ra một cỗ máy cực kỳ phức tạp, và ngẫu nhiên làm sao lại có hẳn một khuôn mẫu tuyệt hảo ngay trong đầu mỗi chúng ta.

Thế giới khoa học đang làm việc hết sức để có thể giải mã cấu tạo bộ não nhằm tìm hiểu bằng cách nào sự tiến hóa lại tạo ra được một thứ hàng khủng tới vậy – những người lạc quan nhất cho rằng chúng ta sẽ đạt được mốc này vào năm 2030. Một khi nhiệm vụ hoàn thành, chúng ta sẽ biết được tất cả những bí mật về cách thức bộ não hoạt động một cách kỳ diệu và hiệu quả như thế nào, và chúng ta có thể lấy đó làm nguồn cảm hứng và ăn cắp những kỹ nghệ của nó. Một ví dụ về cấu trúc máy tính bắt chước não bộ là mạng nơ ron nhân tạo. Ban đầu nó là một mạng các nơ ron kết nối, nối với nhau bởi đầu ra và đầu vào, và nó chẳng biết gì cả – y hệt như não một em bé. Cách để nó “học” là nó sẽ làm thử một nhiệm vụ, ví dụ như nhận dạng chữ viết tay, và ban đầu, những thông tin qua lại và những dự đoán liên tiếp của nó trong việc giải mã từng chữ sẽ hoàn toàn là ngẫu nhiên. Nhưng khi nó được chỉ là nó đã đoán đúng ở đâu, những kết nối trong những đường bắn tin đã tạo ra câu trả lời đúng được củng cố; khi nó bị cho là đoán sai, những kết nối sẽ suy yếu đi. Sau rất nhiều lần thử sai, mạng lưới này, tự nó đã tạo ra những đường nơ ron thông minh và bộ máy đã được tối ưu hóa cho nhiệm vụ này. Bộ não người cũng học theo cách này nhưng phức tạp hơn, và khi chúng ta tiếp tục nghiên cứu bộ não, chúng ta lại khám phá thêm nhiều cách mới mẻ để tận dụng cách vận hành của mạng lưới thần kinh.

Sao chép triệt để hơn có thể là “tái tạo toàn bộ não”, một chiến lược với mục đích là cắt bộ não thật ra thành những lớp thật nhỏ, chụp hình mỗi lát, sử dụng phần mềm để tái tạo chính xác lại một mô hình 3 chiều, và rồi gán nó cho một máy tính thật mạnh. Chúng ta lúc đó sẽ có một máy tính chính thức có khả năng làm mọi điều mà bộ não có thể – nó chỉ cần học và tiếp thu thông tin. Nếu như các kỹ sư thật sự siêu sao, họ sẽ có thể tái tạo lại một bộ não thật với độ chính xác khủng đến mức tính cách và trí nhớ của bộ não sẽ được giữ nguyên một khi cấu trúc của bộ não đã được tải vào trong máy tính. Nếu như bộ não thuộc về Jim ngay trước khi ông này mất, thì máy tính giờ sẽ tỉnh dậy và trở thành Jim (?), và đó sẽ là một AGI rất mạnh, và giờ chúng ta có thể tập trung vào việc biến Jim thành một ASI thông minh không tưởng, và điều này có lẽ sẽ làm ông vui mừng khôn xiết.

Chúng ta còn cách bao xa mới tới được điểm đó? Cho tới nay, chúng ta mới vừa thành công trong việc tái tạo một bộ não giun dẹp dài 1mm, và chứa tổng 302 neuron. Bộ não người có 100 tỷ neuron. Nếu như bạn thấy đây chỉ là một dự án vô vọng, hãy nhớ lại sức mạnh của tăng tốc theo hàm mũ – giờ chúng ta đã thành công trong việc chinh phục một bộ não giun nhỏ bé, não kiến sẽ nhanh chóng nối tiếp, rồi não chuột, và rồi ngạc nhiên chưa! tất cả những điều này đều bỗng chốc trở nên thật hợp lý.

2) Cố gắng bắt tiến hóa phục vụ chúng ta

Rồi thì chúng ta cho là bài thi của đứa nhóc thông minh quá khó chép lại, nên thay vào đó chúng ta có thể thử copy cách học của nó.

Có một điều chúng ta đã biết. Xây dựng một cỗ máy mạnh cỡ bộ não là có khả năng – sự tiến hóa của chính bộ não của chúng ta là một bằng chứng. Và nếu như bộ não là quá khó để tái tạo, chúng ta có thể thay vào đó tái tạo quá trình tiến hóa. Thực tế là, ngay cả khi chúng ta có thể tái tạo bộ não, thì có lẽ cũng chỉ như dựng một máy bay dựa trên việc sao chép các chuyển động vỗ cánh của loài chim – thường thì, máy móc được thiết kế tốt nhất dựa trên hướng tiếp cận mới mẻ theo tính chất máy móc thì hơn là bắt chước hoàn toàn cấu tạo sinh học.

Thế thì làm cách nào chúng ta có thể mô phỏng tiến hóa để tạo ra AGI? Phương pháp có tên là “thuật toán di truyền” (genetic algorithms), sẽ hoạt động như sau: sẽ có một quá trình thực hành và đánh giá diễn ra lặp đi lặp lại (theo đúng cách mà những loài sinh vật “thực hành” khi sống và được “đánh giá” bằng việc liệu chúng có thể sinh sản được hay không). Một nhóm các máy tính sẽ được cho làm các nhiệm vụ, và những máy tính thành công nhất sẽ được lai với nhau bằng cách phối một nửa của từng máy thành một máy mới. Những máy thành công ít hơn sẽ bị loại bỏ. Qua nhiều lần lặp lại, quá trình chọn lọc tự nhiên này sẽ tạo ra những máy tốt hơn nữa. Thách thức ở đây chính là tạo ra một hệ thống đánh giá và vòng lai tự động để quá trình tiến hóa này có thể tự chạy được.

Mặt yếu của sao chép tiến hóa là dường như tiến hóa thích tốn hàng tỷ năm để tạo ra sản phẩm trong khi chúng ta muốn hoàn thành việc này trong có vài thập kỷ.

Nhưng chúng ta có khá nhiều lợi thế so với tiến hóa tự nhiên. Đầu tiên là, tiến hóa chẳng có tầm nhìn xa mấy và chỉ làm việc kiểu ngẫu nhiên – nó tạo ra nhiều phiên bản lỗi hơn là những bản xịn, nhưng chúng ta hoàn toàn có thể điều chỉnh quá trình để nó sẽ chỉ hướng tới những biến đổi có ích và những dị biệt có nghĩa. Thứ hai là, tiến hóa chẳng có mục đích nào cả, kể cả trí tuệ – đôi khi có những môi trường sẽ chọn đào thải trí tuệ cao cấp hơn (vì sử dụng trí tuệ sẽ rất tốn năng lượng). Chúng ta, thay vào đó, có thể đặc biệt điều hướng quy trình này nhắm tới mục đích tăng trí tuệ. Thứ ba là, để chọn lựa trí tuệ, tiến hóa phải đổi mới theo nhiều phương diện để nâng đỡ trí tuệ – như là thay đổi cách tế bào tạo ra năng lượng – trong khi chúng ta có thể gạt bỏ những gánh nặng đó và sử dụng các phương tiện như điện năng. Chẳng phải nghi ngờ gì lắm, chúng ta sẽ nhanh hơn tiến hóa rất nhiều – nhưng cũng chưa rõ liệu chúng ta có đủ nhanh để biến đây thành một chiến lược khả thi không.

3) Đẩy hết mọi trách nhiệm cho máy tính.

Đây là lúc mà các nhà khoa học đã nản đến độ họ gắng viết phần mềm để bài thi tự giải nó. Nhưng nó lại có thể là phương án có triển vọng nhất mà chúng ta có.

Ý tưởng chính là chúng ta sẽ xây dựng một máy tính với hai kỹ năng chính là nghiên cứu AI và viết code để thay đổi chính nó – cho phép nó không chỉ học mà còn tự cải thiện cấu trúc của nó. Chúng ta sẽ dạy máy tính trở thành nhà khoa học máy tính để chúng tự quay vòng sự phát triển của chúng. Và đó sẽ là nhiệm vụ chính của chúng – tìm ra cách để bản thân chúng trở nên thông minh hơn. Bài sau sẽ nói rõ hơn về vụ này.

Tất cả những điều này rất có thể sẽ xảy ra sớm thôi

Tiến bộ nhanh chóng trong lĩnh vực phần cứng và thí nghiệm đổi mới với phần mềm đang đồng thời diễn ra, và AGI có thể lặng lẽ tiến tới với chúng ta rất nhanh chóng và bất ngờ vì hai lý do chính sau đây:

1) Tăng trưởng hàm mũ là rất mãnh liệt và tốc độ phát triển chỉ cỡ như ốc sên cũng có thể tăng lên chóng mặt – hình GIF này là một minh họa hết sức hoàn hảo:

2) Về phần mềm thì, các tiến bộ có thể có vẻ rất chậm, nhưng chỉ cần một cú hích thôi cũng có thể ngay lập tức thay đổi tốc độ tiến bộ (giống như là khoa học, vào cái thời mà loài người nghĩ Trái đất là trung tâm vũ trụ, đã gặp khó khăn trong việc tính toán hoạt động của vũ trụ, và rồi phát hiện ra Trái đất quay quanh Mặt trời bỗng dưng làm mọi sự trôi chảy hết cả). Hoặc là, khi nhắc tới máy tính có khả năng tự cải thiện, nghe có vẻ thật xa xôi nhưng thật ra lại chỉ cần một cú hích nhỏ là nó sẽ trở nên hiệu quả hơn gấp 1000 lần và tiến tới mức trí tuệ con người.

Con đường từ AGI tới ASI

Vào một lúc nào đó, chúng ta sẽ đạt được AGI – những cỗ máy thông minh như con người. Thế là một đống người và máy sống ngang hàng với nhau.

Ôi nghe vầy mà chẳng phải vầy đâu.

Vấn đề là, AGI với mức thông minh và năng lực tính toán như con người vẫn sẽ có những lợi thế đáng kể so với loài người. Ví dụ như:

Phần cứng:

- Tốc độ. Hệ thần kinh của não bộ tối đa đạt tới 200 Hz, trong khi những bộ vi xử lý ngày nay (và chắc hẳn chúng sẽ còn nhanh hơn rất nhiều khi chúng ta đạt mốc AGI) chạy ở mức 2 GHz, tức là nhanh gấp 10 triệu lần so với chúng ta. Và những giao tiếp nội bộ của não, với tốc độ 120 m/s, quá là cùi bắp khi so với tốc độ ánh sáng khi truyền tin của máy tính.

- Kích cỡ và bộ nhớ. Bộ não bị cố định về kích cỡ bởi xương sọ của chúng ta, và dù sao đi nữa nó cũng chẳng to lên được, nếu không thì tốc độ truyền tin 120 m/s sẽ tốn quá nhiều thời gian để truyền tải thông tin từ một tổ chức não tới tổ chức khác. Máy tính có thể bành trướng ra bất kì kích cỡ nào, cho phép nhiều phần cứng hoạt động hơn, một bộ nhớ làm việc (RAM) và một bộ nhớ dài hạn lớn hơn và có mức độ chính xác và khả năng tuyệt vời hơn bộ não rất nhiều.

- Độ tin cậy và sức bền. Không chỉ có bộ nhớ trở nên chính xác hơn. Do những đơn vị truyền tin của máy tính chính xác hơn là neuron thần kinh của chúng ta, chúng sẽ ít bị hoai đi (và có thể được thay thế nếu như bị hư). Bộ não người cũng rất dễ mệt mỏi, trong khi máy tính có thể chạy không ngừng nghỉ, với hiệu suất đạt đỉnh điểm 24/7.

Phần mềm:

- Có thể hiệu chỉnh, nâng cấp, cùng với nhiều khả năng hơn. Không giống như bộ não người, phần mềm máy tính có thể được nâng cấp và sửa chữa cũng như dễ thí nghiệm hơn. Các nâng cấp cũng sẽ có thể được mở rộng ra trong những lĩnh vực mà bộ não người còn yếu. Phần mềm xử lý hình ảnh của loài người cực kỳ tiến bộ, trong khi năng lực kỹ thuật phức tạp của nó lại quá thấp. Máy tính có thể tranh đua với loài người về phần mềm xử lý hình ảnh nhưng đồng thời cũng có thể tối ưu hóa về mặt kỹ thuật hay những mặt khác.

- Năng lực tổng hợp. Loài người đè bẹp các loài khác trong năng lực tổ chức tổng hợp trí tuệ. Bắt đầu với sự phát triển của ngôn ngữ và sự tạo thành những cộng đồng tập trung lớn và đông đảo, tiến lên với những phát minh về chữ viết và in ấn, và giờ tăng lên gấp nhiều lần qua Internet, trí tuệ tổng hợp của loài người là một trong những lý do chính chúng ta vượt mặt những loài khác ở một khoảng cách rất xa. Và máy tính sẽ còn xịn hơn cả chúng ta nữa. Một mạng lưới toàn cầu của AI chạy một chương trình nào đó có thể thường xuyên đồng bộ với chính nó để bất kỳ thứ gì một máy nào học được cũng sẽ được gửi tới toàn bộ các máy khác. Những nhóm này có thể xử lý một nhiệm vụ dưới vai trò một nhóm, bởi vì hẳn sẽ ít có khả năng xuất hiện những ý kiến trái chiều hay động lực lợi ích cá nhân, như chúng ta thấy ở loài người. (10).

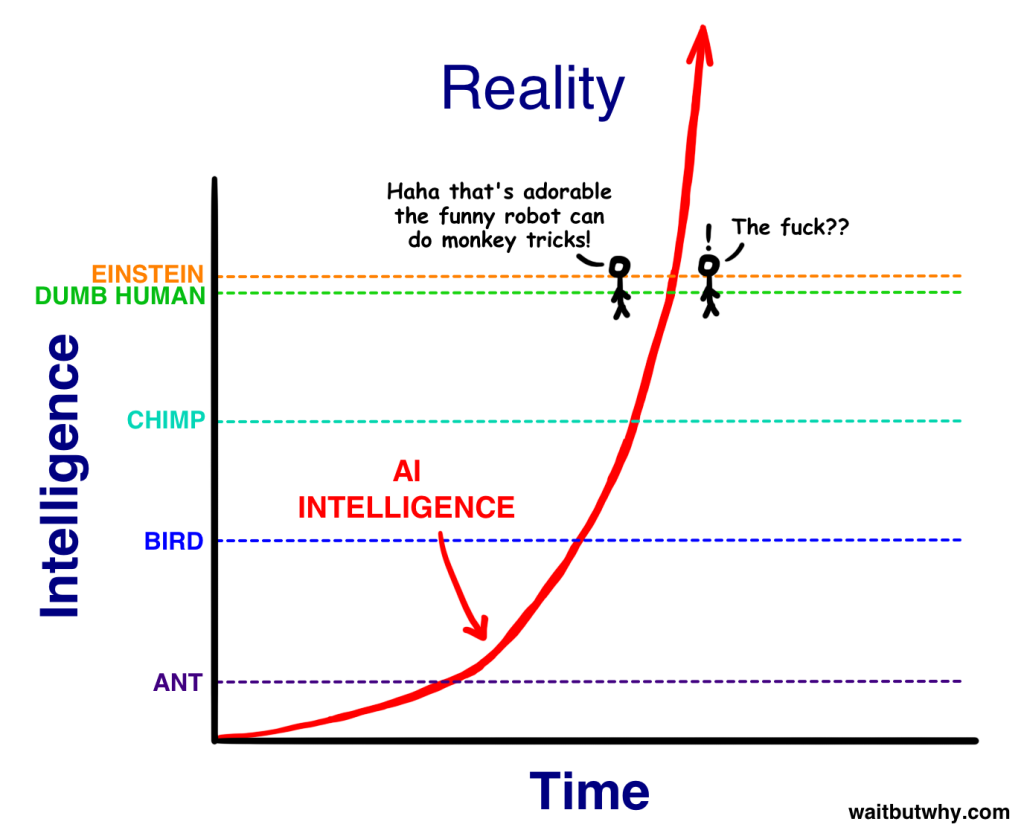

AI, có khả năng trở thành AGI bằng cách tự cải tiến hoạt động của bản thân, cũng sẽ không thấy “mức con người” là một mốc quan trọng gì lắm – đó chỉ là một chỉ dấu có nghĩa với chúng ta – và sẽ chẳng có lý do gì để chỉ dừng lại ở mức con người. Và tính tới những lợi thế mà chúng có so với chúng ta, hiển nhiên là nó chỉ dừng ở mức đó một khoảnh khắc ngắn ngủi trước khi tiến tới lãnh địa siêu trí tuệ.

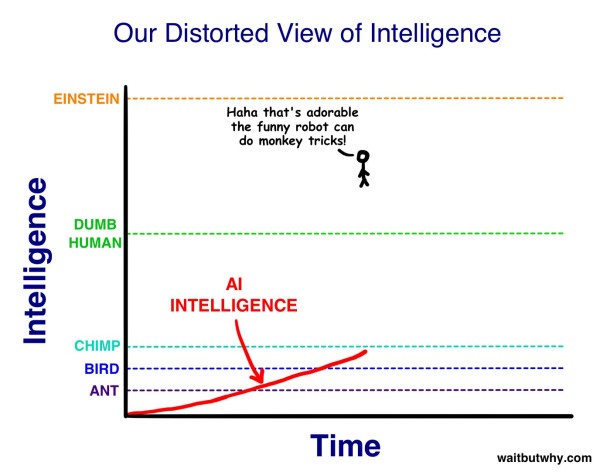

Điều này sẽ làm chúng ta giật mình vãi cả *** khi nó xảy ra. Lý do là từ điểm nhìn của chúng ta, A) trong khi trí tuệ của các loài động vật khác nhau có sai khác, điểm chính yếu là chúng thấp hơn chúng ta rất nhiều, và B) chúng ta nghĩ rằng người thông minh nhất trong loài người sẽ thông minh hơn cực kỳ so với người ngu nhất. Kiểu như thế này:

Vậy nên khi AI phóng tới mức trí tuệ cao hơn chúng ta, chúng ta chỉ coi nó là trở nên thông minh hơn, so với mức loài vật. Rồi đến khi nó đạt tới mức thấp nhất của trí tuệ loài người – Nick Bostrom dùng thuật ngữ “chàng ngốc nhà quê” (village idiot) – chúng ta sẽ kiểu, “Ôi trời, nó như một thằng ngu vầy. Dễ cưng quá!” Chỉ là, trong thang trí tuệ lớn, tất cả loài người, từ chàng nhà quê cho tới Einstein, cũng chỉ cách nhau một khoảng rất nhỏ – nên ngay khi vừa mới đạt mốc chàng ngốc và đạt chuẩn AGI, nó bỗng dưng vọt lên thông minh hơn cả Einstein và chúng ta chẳng biết cái gì vừa lướt qua cả.

Và rồi cái gì… sẽ xảy ra sau đó?

Cuộc bùng nổ trí tuệ

Tôi hy vọng các bạn tận hưởng được khoảng thời gian bình thường vui vẻ, bởi vì khi chủ đề này đã tới bước bất thường và đáng sợ thì nó sẽ cứ như thế mãi. Tôi muốn dừng lại một chút để nhắc lại rằng tất cả những điều tôi vừa nói là thật – là khoa học thật và dự báo thật về tương lai từ một loạt những nhà tư tưởng và khoa học đáng kính nhất. Cứ cố mà nhớ vậy nhé.

Dù sao đi nữa, như tôi đã nói ở trên, phần lớn các mô hình hiện nay để đạt mốc AGI có bao gồm cả việc AI sẽ tiến tới đó thông qua tự cải tiến. Và một khi nó tiến tới AGI, ngay cả các hệ thống cấu thành và phát triển bởi những phương pháp không liên quan tới tự cải tiến thì giờ cũng có thể đủ thông minh để tiến hành tự cải tiến nếu muốn.

Và giờ là lúc chúng ta bàn tới một khái niệm cực khủng: tự hoàn thiện đệ quy (recursive self-improvement). Nó hoạt động như sau –

Một hệ thống AI ở một mốc cố định – ví dụ như là mức chàng ngốc đi – được lập trình với đích nhắm là tự cải thiện trí tuệ của nó. Một khi nó làm được, nó sẽ trở nên thông minh hơn, có lẽ lúc này là ở mức Einstein – nên giờ nó sẽ trơn tru hơn và có thể nhảy vọt những bước lớn hơn. Những bước này làm nó trở nên thông minh hơn rất nhiều bất kỳ người nào, và làm nó có thể nhảy những bước còn xa hơn nữa. Và khi những bước nhảy lớn dần và nhanh dần, AGI sẽ bay vọt lên trên thang trí tuệ và mau chóng đạt tới mức siêu trí tuệ của một ASI. Đây được gọi là cuộc bùng nổ trí tuệ (Intelligence Explosion (11)), và đó là ví dụ tuyệt hảo cho Quy luật Tăng tốc theo cấp số nhân.

Có một vài tranh luận nổ ra trong việc mất bao lâu AI sẽ đạt được mức thông minh như người. Con số trung bình trong một cuộc khảo sát hàng trăm nhà khoa học về việc họ tin bao giờ chúng ta có khả năng lớn hơn trung bình là đã đạt được mốc AGI là năm 2040 (12) – tức là khoảng 25 năm nữa, và nghe cũng không ấn tượng lắm cho tới khi bạn tính tới việc nhiều nhà tư tưởng trong lĩnh vực này cho rằng tiến trình từ AGI tới ASI sẽ cực kỳ chóng vánh. Như kiểu sau đây:

Mất hàng thập kỷ để AI đầu tiên đạt mốc trí tuệ chung ở mức thấp, nhưng rồi nó cũng xảy ra. Một máy tính có thể hiểu được thế giới xung quanh ở mức đứa trẻ 4 tuổi. Đột nhiên, một tiếng đồng hồ sau khi chạm ngưỡng đó, hệ thống này tung ra một thuyết vật lý vĩ đại kết nối giữa thuyết tương đối rộng và lượng tử, một điều mà chưa con người nào có thể làm được một cách rõ ràng. 90 phút sau đó, AI đã trở thành một ASI, thông minh hơn một người tới 170 000 lần.

Siêu trí tuệ ở mức đó nằm quá tầm hiểu biết dù là xa vời nhất của chúng ta, tương tự như một con ong chẳng thể thấm được học thuyết kinh tế của Keynes. Trong thế giới của chúng ta, thông mức tức là đạt 130 điểm IQ và ngu ngốc là 85 điểm – chúng ta không có từ nào mô tả IQ ở mức 12 952.

Điều mà chúng ta biết là sự thống trị toàn diện của loài người trên thế giới gợi ra một luật lệ: trí tuệ sẽ mang lại quyền lực. Tức là một ASI, khi chúng ta đã tạo ra nó, sẽ trở thành thứ có quyền lực nhất trong lịch sử sự sống trên Trái đất, và tất cả những sinh vật sống, bao gồm cả loài người, đều nằm trong lòng bàn tay nó – và điều này có thể xảy ra chỉ sau một vài thập kỷ nữa.

Nếu như bộ não thô ráp của chúng ta có thể tạo ra wifi, vậy thì một thứ thông minh gấp 100 hay 1000 hay 1 tỷ lần chúng ta hẳn sẽ chẳng gặp vấn đề gì với việc điều khiển vị trí của từng nguyên tử một trên thế giới theo mọi cách mà nó muốn, vào bất kỳ lúc nào – tất cả những điều mà chúng ta cho là phép thuật, tất cả những quyền lực của một vị Chúa vạn năng đều sẽ chỉ là một hành vi tầm thường như là bật một cái công tắc đèn đối với chúng ta. Tạo ra công nghệ để đảo ngược tiến trình lão hóa, chữa các loại bệnh dịch, đẩy lùi nạn đói và thậm chí là tiến tới bất tử, thiết lập thời tiết để bảo vệ sự sống tương lai trên Trái Đất – tất cả bỗng dưng đều trở nên có thể. Một khả năng khác là nó sẽ chấm dứt toàn bộ sự sống trên hành tinh này. Như vậy, nếu như một ASI trở thành sự thật, và giờ có một vị Chúa toàn năng trên Trái đất – thì câu hỏi quan trọng bậc nhất đối với chúng ta sẽ là:

Liệu nó có phải là một vị Chúa tốt không?

PHẦN 2

Cuộc cách mạng trí tuệ nhân tạo: Nhân loại sẽ trở nên bất tử hay diệt chủng?

Chúng ta đang phải đối mặt với một vấn đề vô cùng nan giải cần phải giải quyết trong một khoảng thời gian không thể xác định chính xác là bao lâu, một vấn đề mà có lẽ sẽ quyết định vận mệnh của toàn nhân loại. – Nick Bostrom

Xin chào mừng tới với Phần 2 của loạt bài “Chờ đã làm sao lại như này tôi đang đọc cái quái gì vậy tại sao chẳng ai nói gì về vụ này cả.”

Phần 1 bắt đầu với vẻ khá là vô hại, với việc đàm luận về Trí tuệ nhân tạo hẹp (ANI – AI được chuyên môn hóa ở một lĩnh vực hẹp như là thiết lập tuyến đường lái xe hay chơi cờ vua), và sự phổ biến của chúng trong thế giới của chúng ta hiện nay. Sau đó chúng ta đào sâu vào việc tại sao đi từ ANI tới Trí tuệ nhân tạo rộng – AGI (AI thông minh ở cấp độ con người một cách phổ quát) lại khó khăn tới vậy, và chúng ta đàm luận về tốc độ tăng trưởng hàm mũ của công nghệ mà chúng ta đã quan sát được từ quá khứ và từ đó rút ra được rằng AGI có lẽ không còn xa vời như chúng ta thường nghĩ. Phần 1 kết thúc bằng việc tôi tung chưởng rằng sự thật là một khi những cỗ máy này đạt tới mức độ thông minh như con người, tình hình có lẽ sẽ ngay lập tức thành như sau:

Vụ này làm chúng ta ngó chòng chọc vào màn hình, đối diện với sự dữ dội của khả năng xuất hiện Siêu trí tuệ nhân tạo – ASI (AI thông minh vượt trội so với bất kỳ con người nào trên bất kỳ lĩnh vực nào) ngay trong cuộc đời này của chúng ta, và cố gắng tưởng tượng xem chúng ta nên cảm thấy ra sao khi nghĩ về điều này. (1)

Trước khi chúng ta bắt đầu đi sâu hơn, hãy thử nhắc lại một chút về việc đối với một cỗ máy thì sở hữu siêu trí tuệ có nghĩa là như thế nào.

Một sự phân biệt mấu chốt nằm ở sự khác biệt giữa siêu trí tuệ tốc độ và siêu trí tuệ chất lượng. Thường thì, ý nghĩ đầu tiên của một người khi nghĩ tới một cỗ máy siêu thông minh là việc nó thông minh như con người nhưng có thể suy nghĩ với tốc độ nhanh hơn rất nhiều – họ có thể vẽ lên hình ảnh một cỗ máy suy nghĩ như con người nhưng nhanh hơn hàng triệu lần, tức là nó có thể xử lý một vấn đề trong vòng năm phút trong khi với con người sẽ phải mất cả thập kỷ.

Nghe thì cũng ấn tượng đấy, và ASI hẳn là sẽ nghĩ nhanh hơn bất kỳ con người nào – nhưng điều làm nên sự khác biệt chính là lợi thế của nó trong chất lượng của trí tuệ, một điều hoàn toàn khác hẳn. Điều làm con người có khả năng tư duy vượt trội so với loài linh trưởng không phải là sự khác biệt về tốc độ tư duy – mà là việc não người có những mô đun nhận thức phức tạp, cho phép những thứ như là hiểu được ngôn ngữ biểu hình phức tạp hay là lập kế hoạch dài hạn hay là lập luận trừu tượng, mà bộ não linh trưởng không thể xử lý được. Tăng tốc độ xử lý của não linh trưởng lên gấp hàng ngàn lần cũng không giúp nó đạt được tới đẳng cấp của chúng ta – ngay cả khi mất tới một thập kỷ, nó cũng không thể tìm ra cách để sử dụng những công cụ có sẵn để sắp đặt một mô hình tinh vi, trong khi con người dễ dàng làm được điều này chỉ với vài giờ đồng hồ. Có hẳn một số lượng lớn các chức năng nhận thức của con người mà một loài linh trưởng khác chỉ đơn giản là không thể nắm được, dù nó có dành ra bao nhiêu thời gian đi nữa.

Nhưng không chỉ là con linh trưởng không thể làm được những điều mà chúng ta có thể, mà não nó còn không có khả năng nhận thức là những khác biệt đó thậm chí có tồn tại – một con linh trưởng có thể dần quen với khái niệm một con người là như thế nào, hay một tòa nhà chọc trời là ra sao, nhưng nó sẽ không bao giờ có thể hiểu được rằng tòa nhà chọc trời được xây dựng bởi con người. Trong thế giới của nó, tất cả những gì to lớn như vậy cũng chỉ là một phần của tự nhiên, chấm hết, và không chỉ là nó không có khả năng xây nhà, nó còn chẳng thể nhận ra rằng có ai đó có thể xây nên một tòa nhà chọc trời. Đó là hệ quả của một khác biệt nho nhỏ trong chất lượng của trí tuệ.

Và trong thang bậc phạm vi trí tuệ mà chúng ta đang đề cập tới hôm nay, hoặc thậm chí là phạm vi trí tuệ còn hẹp hơn nữa của các loài sinh vật, cái khoảng cách giữa chất lượng trí tuệ của loài người và loài linh trưởng là siêu nhỏ. Trong một bài viết trước đây, tôi mô tả thang bậc năng lực nhận thức của sinh vật bằng một chiếc cầu thang như sau:

Để thẩm thấu được mức độ khủng khiếp của một cỗ máy siêu thông minh, hãy tưởng tượng tới bậc thang màu xanh lá cây sẫm ở phía trên loài người hai bậc. Cỗ máy này chỉ thông minh hơn một chút, nhưng mức độ chất lượng trí tuệ mà nó vượt trên chúng ta cũng đã lớn như là chúng ta đối với loài linh trưởng vậy. Và giống như việc con linh trưởng không thể nào hiểu được rằng nhà cao tầng có thể được xây lên, chúng ta cũng sẽ chẳng bao giờ có khả năng tưởng tượng ra những điều mà cỗ máy nằm trên chúng ta hai bậc có thể làm được, kể cả khi cỗ máy đó có cố giải thích cho chúng ta – chưa kể đến việc tự mình cố hiểu chúng. Và đó chỉ là ở mức hai bậc trên chúng ta thôi. Một cỗ máy nằm trên bậc thứ hai kể từ trên đỉnh thang đối với chúng ta sẽ tương tự như chúng ta đối với loài kiến – nó có thể dành hàng năm trời nỗ lực dạy cho chúng ta những điều cơ bản nhất mà nó biết mà vẫn thành công cốc.

Nhưng thứ siêu trí tuệ mà chúng ta đề cập tới ở đây lại còn là một thứ nằm quá bất kỳ thứ gì trên bậc thang đó. Nếu như một vụ bùng nổ trí tuệ xảy ra – khi mà mỗi lần một cỗ máy trở nên thông minh hơn thì nó cũng càng nhanh chóng tự tăng cường trí tuệ của bản thân lên, cho tới khi nó tăng tốc theo chiều thẳng đứng – một cỗ máy có thể mất hàng năm để đi từ bậc linh trưởng lên bậc ngay trên đó, nhưng có lẽ chỉ mất vài giờ để nhảy thêm một bước nữa khi nó đã đạt tới bậc xanh lá cây sẫm trên chúng ta hai bậc, và đến lúc nó trên chúng ta mười bậc, thì có lẽ nó đã có thể nhảy bốn bậc một lần trong mỗi giây. Đó là lý do vì sao chúng ta cần phải nhận thức rằng khả năng rất cao là rất sớm thôi, ngay sau khi cái tin gây sốt về cỗ máy đầu tiên đạt được mức AGI được tung ra, chúng ta có thể sẽ phải đối mặt với thực tế là chúng ta sẽ phải cùng tồn tại với một thứ nằm ở đây trên thang trí tuệ (hay thậm chí là cao hơn gấp vài triệu lần nữa):

Và vì chúng ta mới vừa nhận định rằng gắng hiểu một cỗ máy trên chúng ta hai bậc là hoàn toàn vô vọng, vậy thì hãy khẳng định chắc chắn một lần cho tất cả, rằng không có cách nào để biết được ASI sẽ làm gì và hệ quả của nó đối với chúng ta là gì. Tin vào điều ngược lại có nghĩa là chẳng hiểu gì về siêu trí tuệ cả.

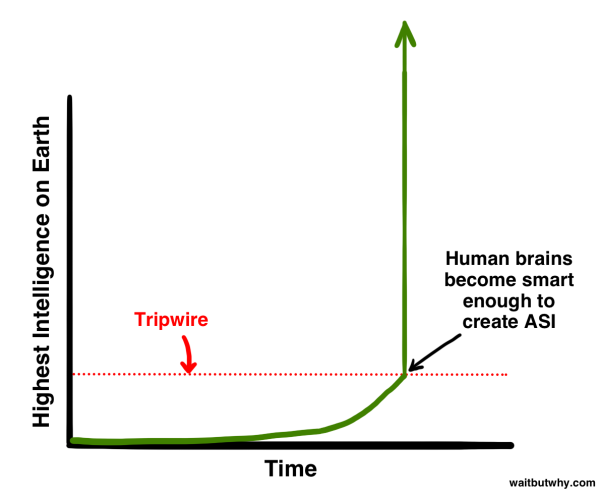

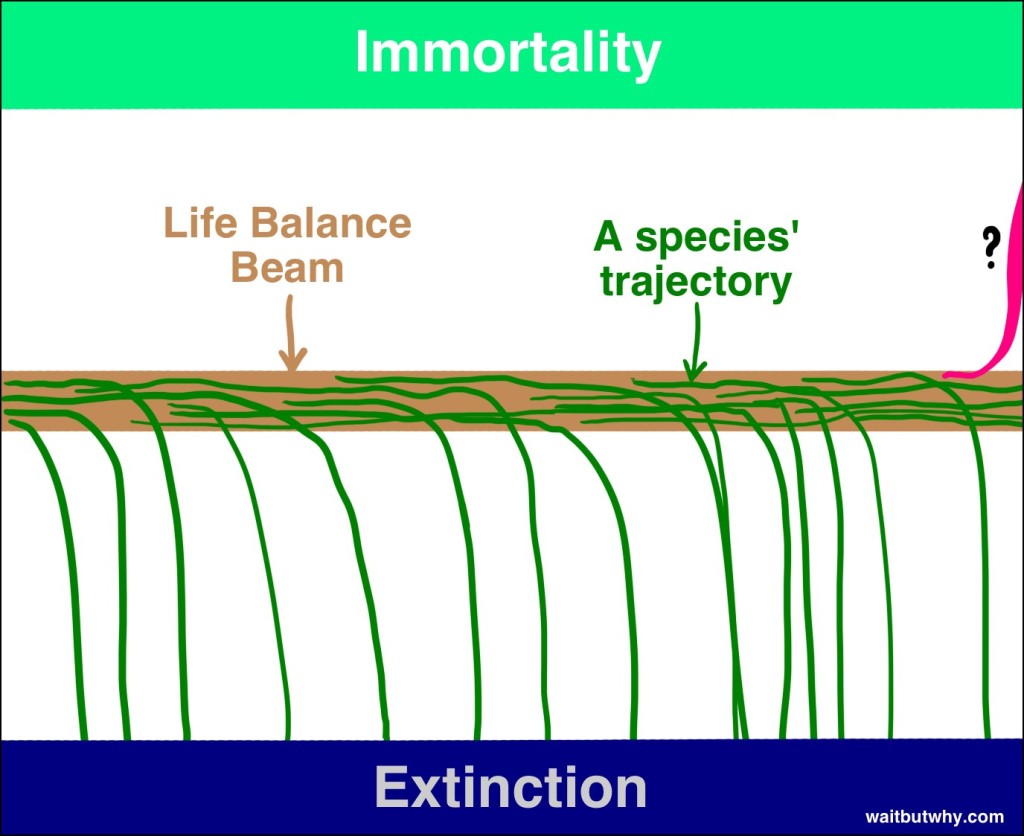

Tiến hóa đã cải thiện bộ não sinh học một cách chậm rãi và từ từ qua hàng trăm triệu năm, và về mặt đó, nếu như loài người tạo ra một ASI, chúng ta đã vượt qua tiến hóa một cách ngoạn mục. Hoặc có thể đó là một phần của tiến hóa – có thể cách mà tiến hóa hoạt động chính là trí tuệ bước từng bước một cho tới khi nó đạt tới mức độ có thể tạo ra siêu trí tuệ, và mức độ đó như một kíp nổ – một ngưỡng châm ngòi – gây nên một vụ bùng nổ thay đổi hoàn toàn thế giới và quyết định một tương lai mới cho tất cả các sinh vật:

Và vì những lý do mà chúng ta sẽ đề cập tới sau đây, một phần lớn trong cộng đồng khoa học tin rằng vấn đề không nằm ở chỗ liệu chúng ta có đạt tới được ngưỡng châm ngòi đó không, mà là khi nào chúng ta sẽ đến đích. Một thông tin khủng đấy chứ.

Vậy thì chúng ta còn lại gì?

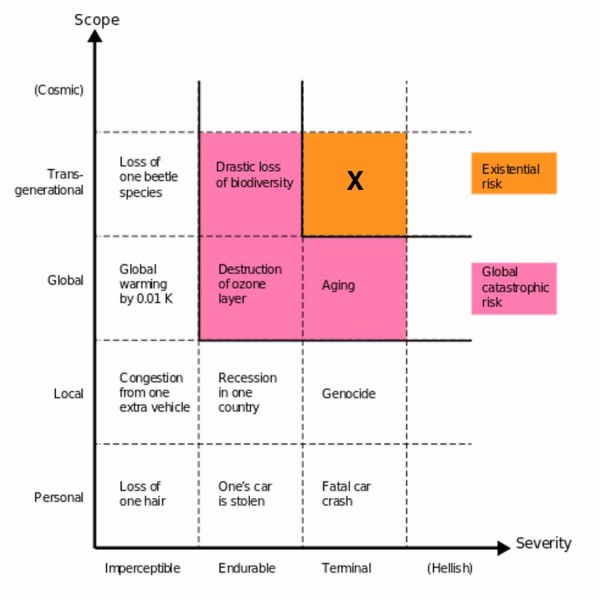

Thật ra thì chẳng ai trên đời này, đặc biệt là tôi, có thể nói cho bạn hay điều gì sẽ xảy ra khi chúng ta đi tới cái mốc đó. Nhưng triết gia và nhà trí tuệ nhân tạo học hàng đầu tại Oxford, Nick Bostrom, tin rằng chúng ta có thể gộp lại tất cả những hệ quả tiềm năng thành hai nhóm lớn.

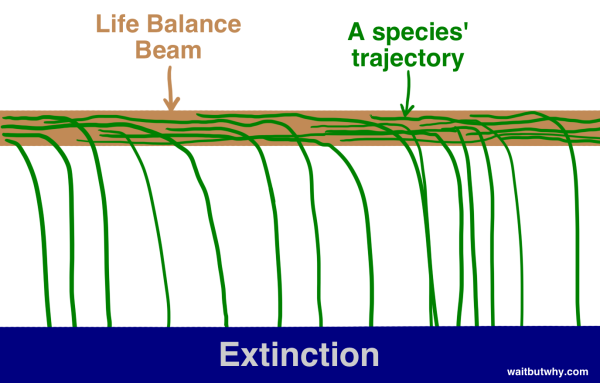

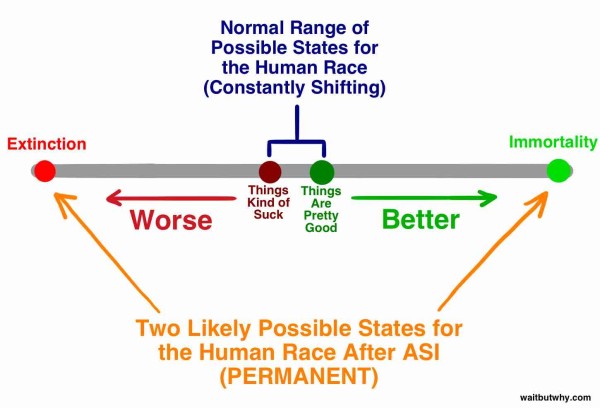

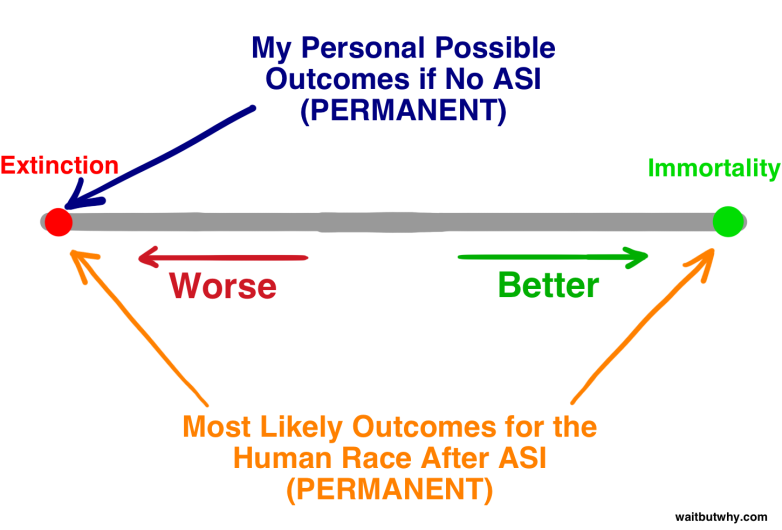

Đầu tiên là, nhìn vào lịch sử thì, chúng ta có thể thấy sự sống làm việc như sau: một loài nảy ra, tồn tại một thời gian, và rồi sau một thời gian, không thể tránh khỏi được, chúng trượt khỏi chùm thăng bằng tồn tại và rơi vào tuyệt chủng –

“Tất cả các loài cuối cùng đều tuyệt chủng” cũng là một quy luật chắc chắn trong lịch sử giống như là “Tất cả mọi người cuối cùng đều chết”. Cho tới nay thì 99,9% số lượng loài đã rơi khỏi chùm cân bằng, và có vẻ rất rõ ràng là nếu như một loài nào đó bám trụ lại trên chùm này đủ lâu thì cũng chỉ còn vấn đề thời gian cho tới khi một loài nào đó, hay một cơn bão của tự nhiên, hay một thiên thể bất ngờ nào đó đá văng nó xuống. Bostrom gọi tuyệt chủng là điểm hút (attractor state) – nơi mà tất cả mọi loài đều ngả về đó và chẳng có loài nào từ đó mà trở về cả.

Và trong khi phần lớn các nhà khoa học mà tôi từng tiếp xúc đều ghi nhận rằng ASI sẽ có khả năng đẩy loài người tới bờ vực tuyệt chủng, rất nhiều người cũng tin rằng nếu như được sử dụng một cách đúng đắn, những khả năng của ASI có thể được dùng để đưa các cá nhân, và theo đó, cả tập thể loài người với tư cách một loài, tới một điểm hút thứ hai – sự bất tử loài. Bostrom tin rằng sự bất tử của loài cũng là một điểm hút y hệt như là tuyệt chủng – chúng ta sẽ đánh bại được cái chết. Vậy nên dù cho tất cả các loài từ trước tới giờ đều đã rơi khỏi chùm thăng bằng và tuyệt chủng, Bostom tin rằng chùm này có hai hướng và chỉ đơn giản là chưa từng có loài nào trên Trái đất đủ thông minh để tìm ra cách rơi về phía bên kia.

Nếu như Bostrom và những người khác đúng, và từ những điều tôi đã được đọc, có vẻ như họ thật sự như vậy, chúng ta sẽ phải tiếp nhận hai sự thật khá là gây sốc:

1) Phát minh ra ASI, lần đầu tiên trong lịch sử, mở ra cơ hội để một loài có thể rơi về phía bất tử trong chùm thăng bằng.

2) Phát minh ra ASI sẽ tạo nên một tác động kinh ngạc tới mức không thể tượng tượng được và sẽ đẩy loài người ra khỏi chùm thăng bằng, về hướng này hay hướng khác.

Rất có thể là khi tiến hóa đạt tới ngưỡng châm ngòi, nó sẽ chấm dứt toàn bộ liên hệ giữa loài người với chùm dây một cách triệt để và tạo nên một thế giới hoàn toàn khác, dù là có hay không còn tồn tại con người.

Có vẻ như câu hỏi duy nhất mà bất kỳ người nào cũng nên đặt ra lúc này là: Khi nào chúng ta đạt tới ngưỡng và chúng ta sẽ ngả về hướng nào khi điều đó xảy ra?

Chẳng ai biết được câu trả lời cho bất kỳ phần nào trong câu hỏi đó, nhưng kha khá những người trong số thông minh nhất đã dành hàng thập kỷ để suy nghĩ về điều đó. Chúng ta sẽ dành phần còn lại của bài viết này để tìm hiểu xem họ đã vạch ra những gì.

—

Hãy bắt đầu với phần đầu tiên của câu hỏi: Khi nào chúng ta sẽ chạm ngưỡng châm ngòi?

hay là Còn bao lâu nữa thì cỗ máy đầu tiên đạt tới mức siêu trí tuệ?

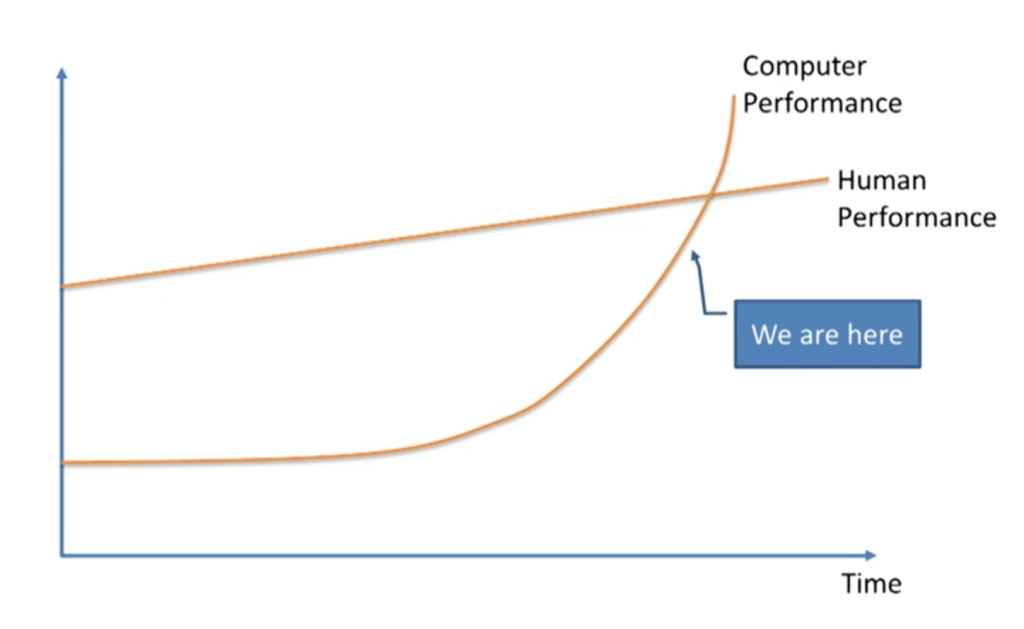

Không ngạc nhiên cho lắm, các ý kiến vô cùng đa dạng dẫn tới một cuộc tranh luận sôi nổi giữa các nhà khoa học và tư tưởng. Nhiều người trong số đó, như giáo sư Vernor Vinge, nhà khoa học Ben Goertzel, nhà đồng sáng lập Sun Microsystems Bill Joy, hay là người nổi tiếng nhất, nhà phát minh và tương lai học Ray Kurzweil, đồng tình với chuyên gia về mô hình hóa bằng máy (machine learning) Jeremy Howard khi ông đề xuất biểu đồ sau trong một buổi TED Talk:

Những người này tin rằng điều này sẽ diễn ra rất sớm – rằng có thể áp dụng luật tăng trưởng hàm mũ ở đây và mô hình hóa bằng máy, dù hiện nay chỉ diễn ra rất từ từ, sẽ bùng nổ trước khi chúng ta nhận ra trong vòng vài thập kỷ tới.

Những người khác, như nhà đồng sáng lập Microsoft Paul Allen, nhà tâm lý học Gary Marcus, nhà khoa học máy tính NYU Ernest Davis, và doanh nhân công nghệ Mitch Kapor, tin rằng những nhà tư tưởng như Kurweil đang đánh giá quá thấp tầm cỡ thực sự của thử thách và tin rằng chúng ta chưa tiến tới gần ngưỡng tới mức đó.

Đội của Kurweil sẽ phản pháo rằng điều duy nhất bị đánh giá thấp ở đây chính là sự coi thường tăng trưởng hàm mũ, và họ sẽ so sánh những người hoài nghi với những người nhìn vào những mầm mống nảy nở chậm rãi của mạng internet vào năm 1985 để tranh luận rằng nó sẽ chẳng đi tới đâu trong tương lai gần.

Những người hoài nghi có thể sẽ phản bác rằng tiến trình cần thiết để có thể tiến lên về mặt trí tuệ cũng sẽ tăng lên theo hàm mũ về độ khó với mỗi bước tiến tiếp theo, và sẽ loại trừ tính tăng theo hàm mũ của tiến bộ công nghệ. Và cứ thế.

Một nhóm thứ ba, bao gồm Nick Bostrom, tin rằng chẳng nhóm nào có cơ sở để dám chắc về mặt thời gian và ghi nhận cả hai điều rằng A) điều đó hoàn toàn có thể xảy ra trong tương lai gần và B) chẳng có gì để dám chắc về điều đó; nó cũng hoàn toàn có thể xảy ra trong một tương lai khá xa.

Những người khác, như triết gia Hubert Dreyfus, tin rằng cả ba nhóm đều quá ngây thơ khi cho rằng có cái ngưỡng đó, tranh luận rằng khả năng cao là ASI thậm chí chẳng bao giờ có thể đạt được nữa.

Vậy chúng ta có thể rút ra được gì khi xem xét tất cả những luồng quan điểm này?

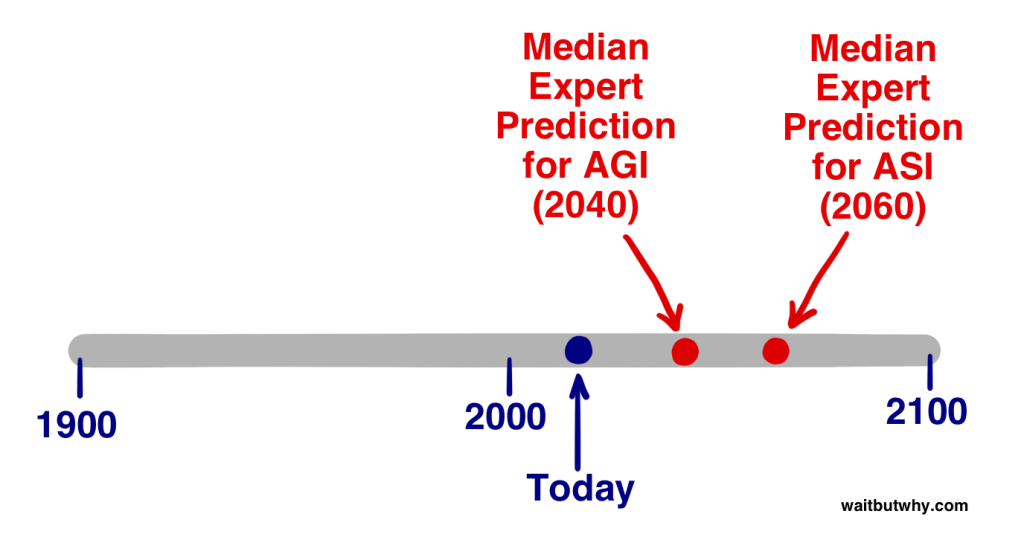

Vào năm 2013, Vincent C. Müller và Nick Bostrom đã tiến hành một khảo sát với hàng trăm chuyên gia về AI trong một loạt hội thảo về câu hỏi sau: “Trong giới hạn câu hỏi này, giả định rằng những hoạt động khoa học của loài người tiếp diễn mà không bị ngáng trở nào đáng kể. Bạn cho rằng tới năm nào sẽ có khả năng (10%/50%/90%) là xuất hiện HLMI (Human-level machine intelligence – hay là AGI)?” Nó yêu cầu người tham gia ghi xuống một năm lạc quan (năm mà họ tin rằng có khả năng 10% là chúng ta đạt tới AGI), một dự đoán thực tế (năm mà họ tin rằng có 50% khả năng xuất hiện AGI – hay có thể hiểu là sau năm đó họ cho rằng khả năng tồn tại AGI là cao hơn khả năng không tồn tại), và một dự đoán an toàn (năm gần nhất mà họ có thể đoán với mức chắc chắn 90% rằng chúng ta có thể có AGI). Tổng hợp dữ liệu lại cho ta kết quả sau: (2)

Năm lạc quan trung bình(10% khả năng): 2022

Năm thực tế trung bình (50% khả năng): 2040

Năm bi quan trung bình (90% khả năng): 2075

Vậy là ở mức trung bình người tham gia nghĩ rằng chúng ta có khả năng tương đối sẽ đạt được AGI trong vòng 25 năm tới. Câu trả lời ở mức 90% trung bình vào năm 2075 có nghĩa là nếu bây giờ bạn là một thiếu niên, thì người tham gia ở mức trung bình, cùng với hơn một nửa nhóm chuyên gia về AI, khá chắc chắn rằng AGI sẽ xuất hiện trong cuộc đời bạn.

Một nghiên cứu khác được tiến hành gần đây bởi tác giả James Barrat tại Hội thảo AGI thường niên của Ben Goertzel, đã bỏ số phần trăm đi mà chỉ hỏi rằng khi nào người tham gia cho rằng chúng ta sẽ đạt tới AGI – cho tới năm 2030, năm 2050, sau năm 2100, hay là không bao giờ. Kết quả: (3)

Năm 2030: 42% tổng số người tham gia

Năm 2050: 25%

Năm 2100: 20%

Sau năm 2100: 10%

Không bao giờ: 2%

Khá là tương đồng với kết quả của Müller và Bostrom. Trong khảo sát của Barrat, hơn hai phần ba số người được hỏi tin rằng AGI sẽ xuất hiện trước năm 2050 và gần một nửa dự đoán sự xuất hiện của AGI trong vòng 15 năm tới. Cũng đáng chú ý như vậy là chỉ có 2% số người được hỏi cho rằng AGI sẽ không xuất hiện trong tương lai.

Nhưng AGI không phải là cái ngưỡng châm ngòi đã được nhắc tới, mà là ASI. Vậy những chuyên gia cho rằng tới bao giờ chúng ta sẽ đạt được ASI?

Müller và Bostrom đồng thời hỏi các chuyên gia rằng liệu họ có thấy khả năng cao là chúng ta sẽ đạt tới ASI A) trong vòng 2 năm sau khi đạt tới AGI (hay có thể hiểu là một cuộc bùng nổ trí tuệ gần như ngay lập tức), và B) trong vòng 30 năm. Kết quả là: (4)

Câu trả lời trung bình đặt cuộc chuyển hóa từ AGI tới ASI trong vòng 2 năm ở mức 10% khả năng, nhưng một cuộc chuyển hóa dài hơn trong vòng 30 năm hay ít hơn ở mức 75% khả năng.

Từ số liệu này chúng ta không biết được độ dài của quá trình chuyển hóa mà người tham gia trung bình sẽ đoán là bao nhiêu ở mức 50%, nhưng để hình dung một cách tương đối, dựa trên hai câu trả lời trên, chúng ta hãy coi rằng họ sẽ nói con số này là 20 năm. Vậy thì ý kiến trung bình – con số nằm ngay chính trung tâm của giới chuyên gia AI – tin rằng dự đoán thực tế nhất về thời điểm chúng ta đạt ngưỡng ASI là [dự đoán năm 2040 về AGI + suy đoán tương đối rằng sẽ mất 20 năm để chuyển từ AGI sang ASI] = 2060.

Đương nhiên, tất cả những số liệu trên đều chỉ đơn thuần là suy đoán, và chúng cũng chỉ đại diện cho mức trung bình của giới chuyên gia AI, nhưng nó có thể cho chúng ta thấy rằng một phần lớn những người hiểu biết nhất về lĩnh vực này sẽ đồng ý rằng 2060 là một suy đoán rất hợp lý cho sự xuất hiện của một ASI có thể thay đổi thế giới. Chỉ trong vòng 45 năm nữa thôi.

Rồi, giờ thì tới phần thứ hai của câu hỏi trên: Khi chúng ta đã đạt ngưỡng châm ngòi rồi, thì chúng ta sẽ ngả về phần nào của chùm thăng bằng?

Siêu trí tuệ sẽ mang lại quyền lực khủng khiếp – và câu hỏi quan trọng nhất cho chúng ta là:

Ai hay cái gì sẽ điều khiển quyền năng ấy, và động lực của họ là gì?

Câu trả lời sẽ quyết định liệu ASI sẽ là một công nghệ tuyệt vời không tưởng, một công nghệ tệ hại không thể hiểu nổi, hay là ở giữa khoảng đó.

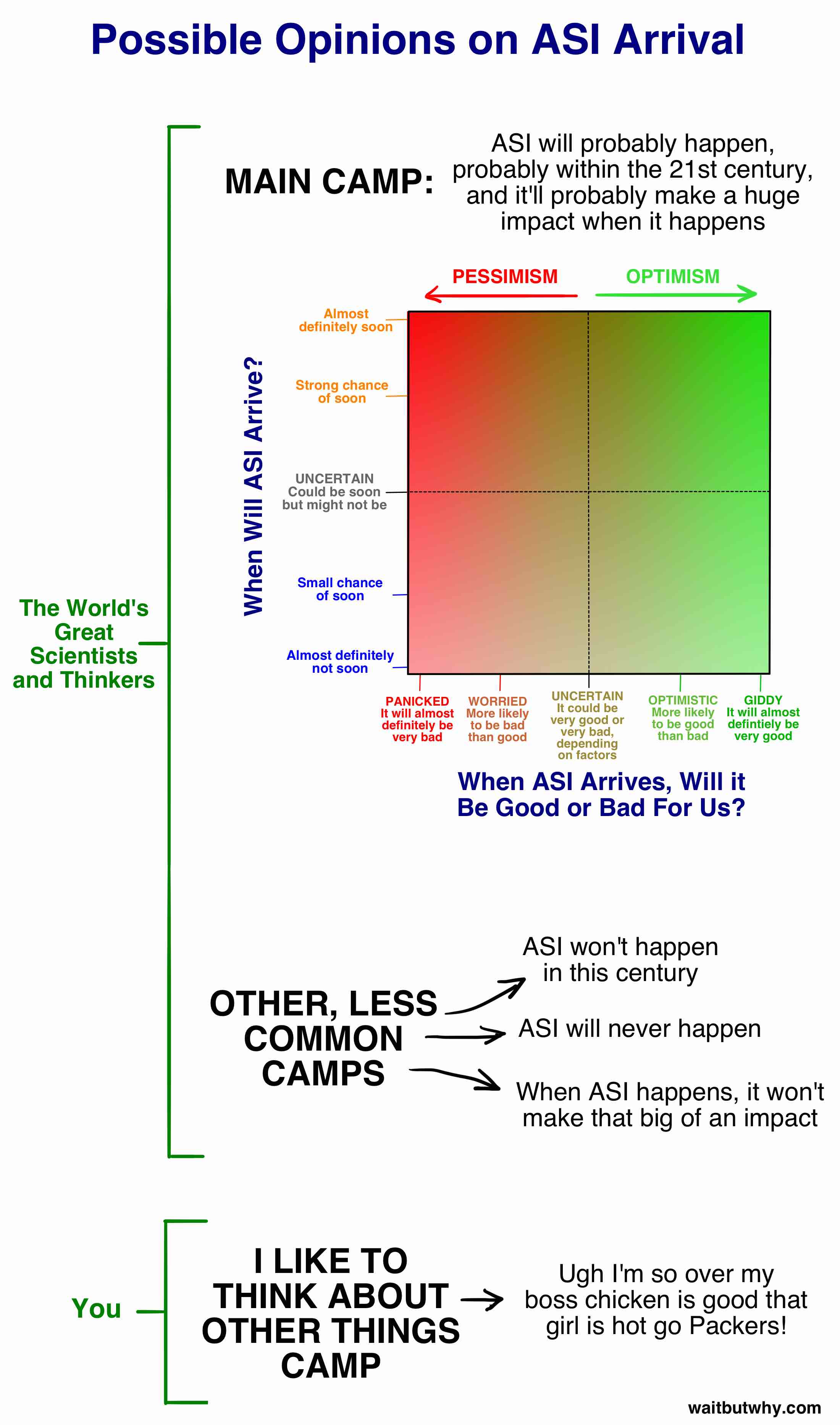

Đương nhiên, giới chuyên gia lại một lần nữa bất đồng quan điểm và đang tham gia một cuộc tranh luận rất sôi nổi về câu trả lời cho câu hỏi đó. Bản khảo sát của Müller và Bostrom cũng yêu cầu người tham gia gán một con số khả năng cho những tác động có thể có của AGI đối với nhân loại và câu trả lời trung bình là có 52% khả năng rằng kết quả sẽ hoặc là tốt hoặc là cực kỳ tốt và 31% khả năng rằng kết quả sẽ hoặc là xấu hoặc là cực kỳ xấu. Đối với một kết quả trung dung thì tỷ lệ trung bình chỉ là 17%. Nói như vậy nghĩa là những người biết nhiều nhất về điều này khá chắc rằng nó sẽ là một chấn động lớn. Cũng cần chú ý rằng những con số này là dành cho phát minh ra AGI – nếu như câu hỏi là về ASI, tôi tin rằng tỷ lệ trung bình cho kết quả trung dung sẽ còn thấp hơn nữa.

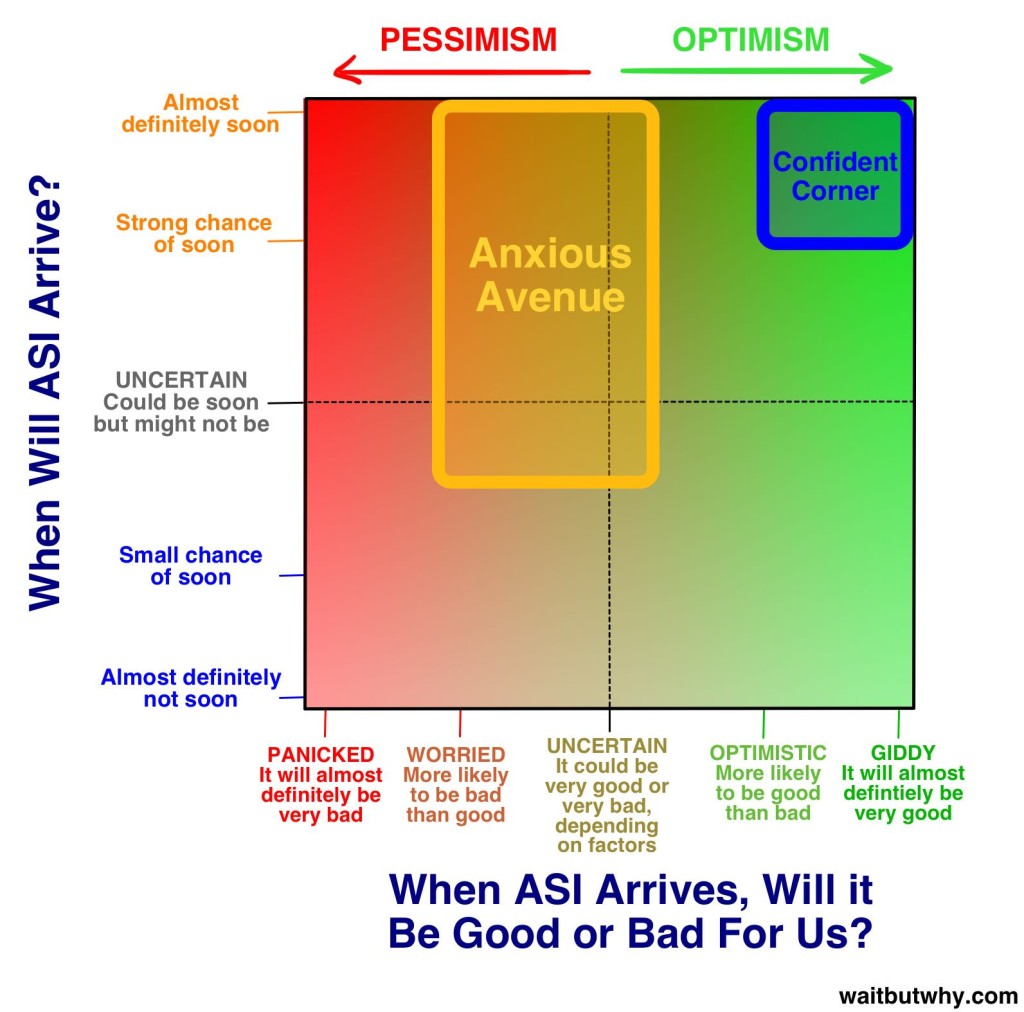

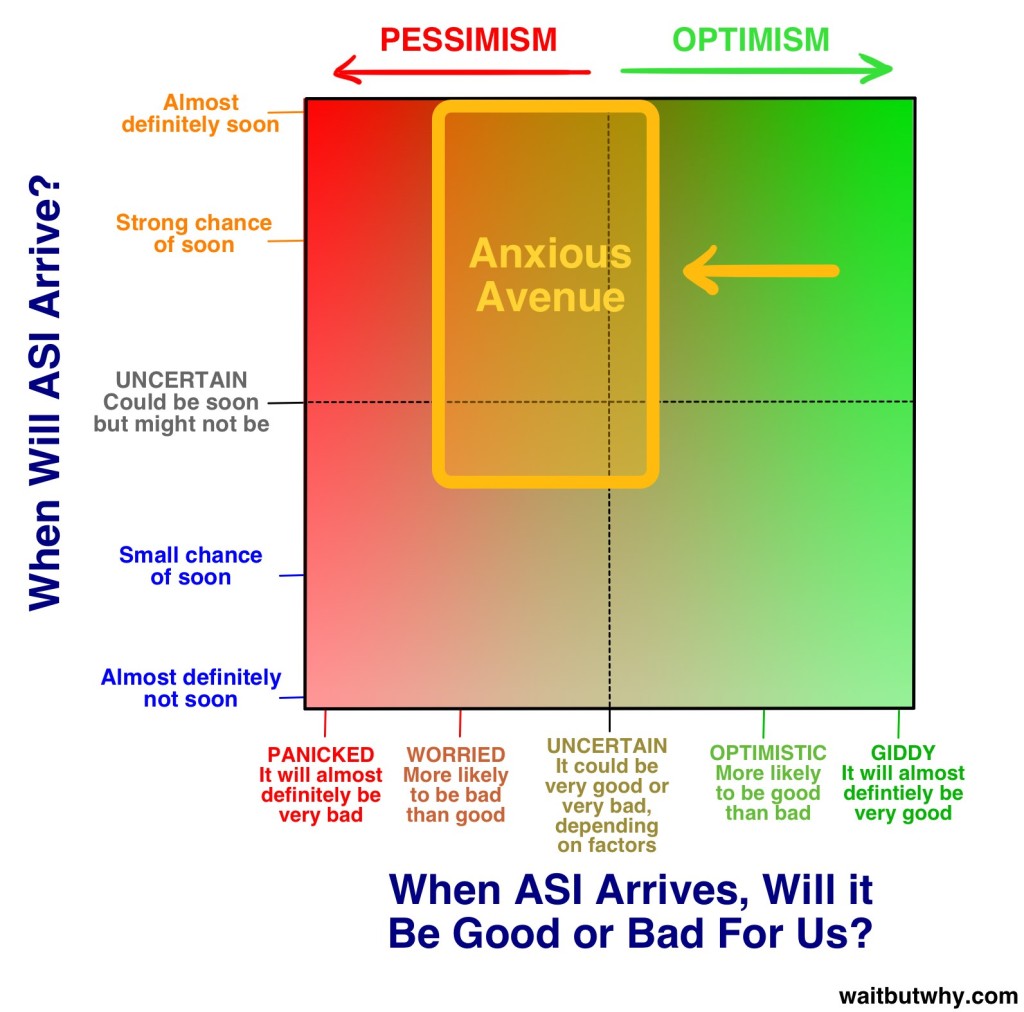

Trước khi chúng ta đào sâu hơn vào vấn đề hệ quả tốt hay xấu, hãy thử kết hợp hai phần “bao giờ nó sẽ xảy ra?” và phần “nó sẽ tốt hay xấu?” thành một biểu đồ tổng hợp các góc nhìn của những chuyên gia phù hợp nhất:

Chúng ta sẽ bàn kỹ hơn về những quan điểm trong Khu chính trong ít phút nữa, nhưng trước tiên – bạn ngả về phía nào? Thực ra tôi biết rõ bạn nghĩ ra sao, vì tôi cũng đã từng nghĩ tương tự như bạn trước khi tìm hiểu về chủ đề này. Một số lý do mà phần lớn mọi người ít khi nghĩ về vấn đề này:

- Như đã được nhắc đến ở Phần 1, phim ảnh khá là dễ gây hiểu lầm khi đưa ra những viễn cảnh không thực tế về AI khiến chúng ta cảm thấy như AI không phải là vấn đề gì nghiêm trọng lắm. James Barrat so sánh tình huống này với phản ứng của chúng ta nếu như Trung tâm Kiểm soát dịch bệnh đưa ra một thông cáo nghiêm túc về nguy cơ xuất hiện ma cà rồng trong tương lai. (5)

- Do một thứ gọi là thiên kiến nhận thức (cognitive biases), chúng ta thường khó tin một điều gì đó là thật cho tới khi thấy bằng chứng. Tôi chắc rằng những nhà khoa học máy tính vào năm 1988 thường xuyên trao đổi về tầm ảnh hưởng của mạng internet trong tương lai, nhưng đại chúng có lẽ chẳng thật sự nghĩ là nó sẽ thay đổi cuộc sống của mình cho tới khi nó thật sự thay đổi cuộc sống của chúng ta. Một phần lý do là vì máy tính không thể làm được những thứ như vậy vào năm 1988, nên người ta nhìn vào máy tính và nghĩ, “Thật sao? Cái thứ này sẽ làm thay đổi cuộc sống á?” Trí tưởng tượng của họ bị hạn chế bởi những kinh nghiệm cá nhân về một chiếc máy tính, làm cho việc tưởng tượng máy tính có thể trở nên như thế nào biến thành cực kỳ khó khăn. Điều tương tự đang diễn ra với AI. Chúng ta nghe rằng có thể nó sẽ là một thứ rất lớn lao, nhưng vì nó chưa xảy ra, và vì trải nghiệm của chúng ta với những AI khá thiếu khả năng trong thế giới hiện nay, chúng ta rất khó thật sự tin rằng chúng sẽ thay đổi thế giới một cách đáng kinh ngạc. Và thiên kiến đó là thứ các chuyên gia đang phải đối mặt khi họ nỗ lực tìm đủ mọi cách để lôi kéo sự chú ý của chúng ta giữa hàng loạt những tiếng ồn của cuộc sống hàng ngày của mỗi người.

- Kể cả khi chúng ta tin vào điều này – có bao nhiêu lần trong ngày hôm nay bạn nghĩ qua rằng rồi bạn sẽ không tồn tại trong phần lớn thời gian của vĩnh cửu? Không nhiều lắm, đúng không? Kể cả khi nó là một sự thật dữ dội hơn nhiều bất kỳ thứ gì bạn đang làm ngày hôm nay? Đó là do não của chúng ta thường tập trung vào những thứ nhỏ nhặt trong cuộc sống thường nhật, bất kể tình trạng dài hạn mà chúng ta đang phải đối mặt có điên rồ đến thế nào. Đó đơn giản chỉ là cách mà não chúng ta hoạt động mà thôi.

Một trong những mục tiêu của hai bài viết này là nhằm kéo bạn ra khỏi Khu Tôi Muốn Nghĩ Về Những Chuyện Khác Hơn và chuyển sang một trong những Khu của chuyên gia, kể cả khi bạn chỉ đứng ở điểm giao nhau của hai đường chấm trong hình vuông phía trên, hoàn toàn không chắc chắn về bất kì cái gì.

Trong quá tình nghiên cứu, tôi đã bắt gặp hàng tá các luồng quan điểm khác nhau về chủ đề này, nhưng tôi mau chóng chú ý rằng phần lớn các quan điểm nằm trong một khu vực mà tôi gọi là Khu chính, cụ thể hơn, hơn ba phần tư số chuyên gia rơi vào trong hai Phân khu nhỏ trong Khu chính.

Chúng ta sẽ đào sâu vào cả hai phân khu này. Hãy bắt đầu với điều vui vẻ hơn –

Tại sao tương lai có thể là một giấc mơ tuyệt vời nhất với chúng ta

Khi tôi tìm hiểu về thế giới AI, tôi thấy có một số lượng lớn tới đáng kinh ngạc những người đứng ở vị trí này:

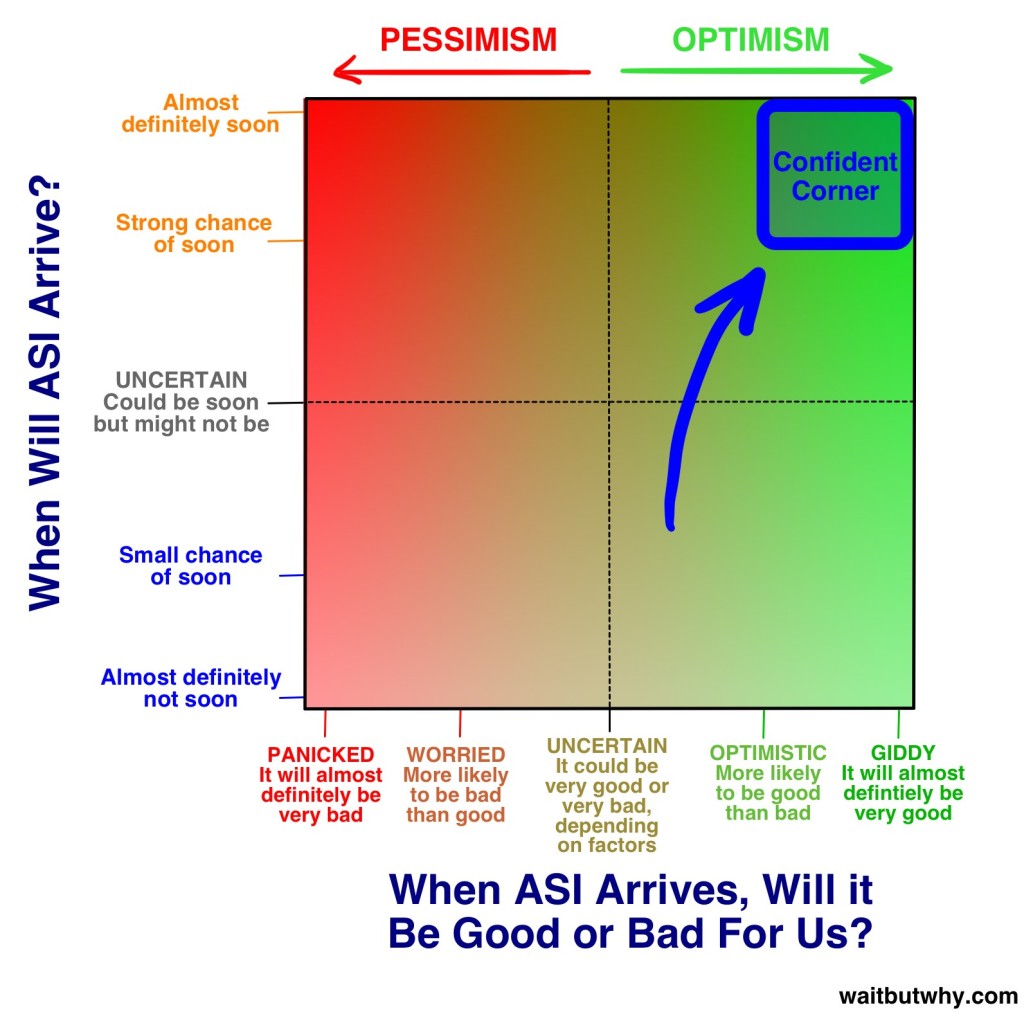

Những người sống trong Góc Tự Tin như muốn nổ tung vì hào hứng. Họ hướng tầm nhìn về phía vui vẻ của chùm thăng bằng và tin rằng đó là nơi tất cả chúng ta đều đang đi tới. Đối với họ, tương lai là tất cả những gì họ có thể mong đợi, và nó sẽ tới vừa kịp lúc.

Điều phân biệt họ với những nhà tư tưởng khác mà chúng ta sẽ bàn tới sau không phải là khát khao về một chiều hướng hạnh phúc của tương lai – mà là sự tự tin rằng đó là nơi chúng ta sẽ tới.

Khởi nguồn của sự tự tin này thì lại còn phải xem xét. Những nhà phê bình tin rằng nó đến từ một sự hào hứng đến mù quáng làm cho họ lờ tịt đi hoặc phủ nhận những hệ quả tiêu cực có thể xảy ra. Nhưng những người tin tưởng thì cho rằng quả là ngây thơ khi vẽ ra một viễn cảnh của ngày tận thế trong khi nhìn một cách tổng quát, công nghệ đã và có lẽ sẽ tiếp tục giúp đỡ chúng ta hơn là làm hại chúng ta.

Chúng ta sẽ nói về cả hai phía, và bạn có thể tự đưa ra quan điểm của mình trong lúc đọc bài, nhưng trong phần này, hãy đặt sự nghi ngại sang một bên và thử đưa mình nhìn vào những điều hay ho có thể xảy ra ở phần này của chùm thăng bằng – và gắng tiếp nhận sự thật rằng những điều mà bạn đang đọc hoàn toàn có thể xảy ra. Nếu như bạn cho một người ở thời săn bắt hái lượm xem thế giới có nơi trú ẩn trong nhà thoải mái tiện nghi, công nghệ và sự dồi dào của cải vật chất, cảnh đó sẽ giống như là phép thuật viễn tưởng đối với anh ta – chúng ta cần phải thật khiêm tốn để ghi nhận rằng hoàn toàn có thể đây sẽ là một chuyển biến vĩ đại tương tự trong tương lai chúng ta.

Nick Bostrom mô tả ba cách mà một hệ thống AI siêu trí tuệ có thể hoạt động: (6)

Như một Kẻ-biết-tuốt, trả lời gần như bất kỳ câu hỏi nào được đặt ra cho nó một cách chuẩn xác, bao gồm cả những câu hỏi phức tạp mà loài người khó có thể trả lời một cách dễ dàng: – như là Làm thế nào để sản xuất một động cơ xe hơi hiệu suất cao hơn? Google là một dạng kẻ-biết-tuốt thô sơ.

Như một Thần đèn, thi hành mọi mệnh lệnh bậc cao được đưa ra cho nó – Sử dụng một máy lắp ráp phân tử để xây dựng một động cơ xe hơi mới với hiệu suất cao hơn – và rồi chờ đợi mệnh lệnh tiếp theo.

Như một Đấng tối cao, được đưa cho những mục tiêu mở chung chung và được cho phép vận hành tự do trong thế giới, tự đưa ra những quyết định cho chính nó để tiến hành một cách tốt nhất – Tạo ra một cách nhanh hơn, rẻ hơn và an toàn hơn xe hơi để con người có thể di chuyển một cách riêng tư.

Những câu hỏi này có vẻ phức tạp đối với chúng ta, nhưng đối với siêu trí tuệ thì cũng chỉ giống như có ai đó hỏi chúng ta cách xử lý tình huống “Bút chì của tôi rơi khỏi cái bàn”, mà bạn sẽ xử lý bằng cách nhặt nó lên và đặt nó lại trên bàn.

Eliezer Yudkowsky, một người cư trú tại Đường E Ngại trên biểu đồ phía trên của chúng ta, đã tóm lại một cách tuyệt vời:

Không có vấn đề nào là khó khăn, chỉ có những vấn đề khó đối với một mức độ nhất định của trí tuệ. Tiến thêm một bước nhỏ [trên thang trí tuệ], và một vài vấn đề sẽ bất chợt chuyển từ “bất khả thi” sang “hiển nhiên.” Tiến thêm một bước đủ lớn và tất cả bỗng đều trở thành hiển nhiên. (7)

Có rất nhiều nhà khoa học, nhà phát minh và doanh nhân đầy nhiệt huyết cư ngụ ở Góc Tự Tin – nhưng để có một chuyến du hành tới nơi tươi sáng nhất trong chân trời AI, chỉ có một người mà chúng ta muốn mời làm hướng dẫn viên.

Ray Kurzweil là một nhân vật gây phân cực mạnh mẽ. Trong quá trình đọc, tôi đã thấy tất cả các quan điểm từ tôn thờ ông và tư tưởng của ông như Chúa cho tới sự khinh miệt rõ ràng. Những quan điểm khác thì nằm đâu đó trong khoảng giữa – tác giả Douglas Hofstadter, khi thảo luận về những ý tưởng trong sách của Kurweil, đã diễn đạt rằng “như thể là bạn vừa ăn một đống thức ăn tuyệt hảo trộn lẫn với phân chó và bạn chẳng thế phân biết được cái gì tốt hay tệ nữa.”

Dù bạn có thích những ý tưởng của ông hay không, tất cả đều đồng tình rằng Kurzweil rất ấn tượng. Ông bắt đầu sáng chế từ thời thiếu niên và trong những thập niên sau đó, ông đã mang lại một số sáng chế mang tính đột phá, bao gồm máy quét phẳng (flatbed scanner) đầu tiên, máy quét đầu tiên có thể chuyển văn tự thành ngôn ngữ nói (giúp người mù có thể đọc được chữ viết thông thường), đàn synthesizer đầu tiên (chiếc đàn piano điện thật sự đầu tiên), và máy nhận diện ngôn ngữ nói với vốn từ rộng được quảng bá thương mại rộng rãi đầu tiên. Ông cũng là tác giả của năm cuốn sách bán chạy nhất nước. Ông nổi tiếng bởi những dự đoán của mình và có một thành tích dự đoán trúng tương đối cao – bao gồm dự đoán từ những năm cuối thập kỷ 80, thời kỳ mà mạng internet vẫn là một thứ bí hiểm, rằng nó rồi sẽ trở thành một hiện tượng toàn cầu. Kurzweil đã được gọi là “thiên tài không ngừng nghỉ” bởi tờ Thời Báo Phố Wall, “cỗ máy tư duy tối thượng” bởi Forbes, “ người kế thừa xứng đáng của Edison” bởi tạp chí Inc., và “người giỏi nhất tôi biết về dự đoán tương lai của trí tuệ nhân tạo” bới Bill Gates. (9) Vào năm 2012, nhà đồng sáng lập Google Larry Page đã tiếp xúc với Kurzweil và đề nghị ông làm việc với tư cách giám đốc kỹ thuật của Google. Vào năm 2011, ông đã đống sáng lập ra đại học Singularity, được tổ chức bởi NASA và được tài trợ một phần bới Google. Một cuộc đời không tệ.

Đoạn tiểu sử này khá là quan trọng. Khi Kurzweil trình bày dự đoán của ông về tương lai, nghe ông cứ như thể đang phê cần vậy, và điều điên rồ ở đây là sự thật không hề như thế – ông là một người hết sức thông minh, hiểu biết và hoàn toàn sáng suốt. Bạn có thể nghĩ rằng ông đã sai khi dự đoán về tương lai, nhưng ông không phải là một kẻ đần độn. Biết rằng ông là một nhân vật đáng tin cậy khiến tôi thấy vui sướng, bởi khi tôi đã biết được những dự đoán về tương lai của ông, tôi cực kỳ mong là ông đúng. Và bạn cũng vậy. Khi bạn nghe về những dự đoán của Kurzweil, được đồng tình bởi những nhà tư tưởng thuộc Góc Tự Tin như Peter Diamandis và Ben Goertzel, bạn sẽ thấy không khó hiểu tại sao ông lại thu thập được một lượng lớn những người ủng hộ nhiệt tình đến vậy – họ được gọi là những “singularitarian”. Ông nghĩ rằng tương lai sẽ như thế này:

Dòng thời gian

Kurzweil tin rằng máy tính sẽ đạt được mốc AGI vào năm 2029 và rằng tới năm 2045, chúng ta không chỉ có được ASI, mà còn có một thế giới mới không tưởng tượng nổi – thời điểm mà ông gọi là điểm dị biệt (singularity). Dòng thời gian mà ông đưa ra từng bị coi là quá sức lạc quan, và cho tới giờ nhiều người vẫn coi nó như vậy, nhưng trong 15 năm trở lại đây, những tiến trình đạt được về các hệ thống ANI đã đưa giới chuyên gia AI đã trở nên đông đảo hơn tới gần hơn với dòng thời gian của Kurzweil. Những dự đoán của ông vẫn là tương đối tham vọng đối với một người tham gia trung bình trong khảo sát của Müller và Bostrom (AGI vào năm 2040, ASI vào năm 2060), nhưng cũng không hẳn là cách xa lắm.

Mô tả của Kurzweil về điểm dị biệt năm 2045 là nó sẽ xảy ra do ba cuộc cách mạng đồng thời trong công nghệ sinh học, công nghệ nano, và mạnh mẽ hơn hết, là AI.

Trước khi chúng ta đi tiếp – công nghệ nano xuất hiện trong phần lớn mọi thứ bạn đọc về tương lai của AI, vậy nên hãy lướt qua ô màu xanh này trong một phút để chúng ta có thể bàn luận về nó –

Ô xanh về Công nghệ Nano

Công nghệ Nano là từ dùng để chỉ công nghệ được sử dụng để xử lý vật chất với kích cỡ từ 1 tới 100 nano mét. Một nano mét bằng một phần tỷ mét, hay là một phần triệu mili mét, và giới hạn từ 1 tới 100 này bao gồm vi rút (khoảng 100 nm), DNA (rộng cỡ 10 nm), và những thứ nhỏ như các phân tử lớn ví dụ như hemoglobin (5 nm) và phân tử cỡ trung như glucose (1 nm). Nếu như/khi chúng ta chinh phục được công nghệ nano, bước tiếp theo sẽ là khả năng điều khiển những nguyên tử độc lập, với kích cỡ chỉ nhỏ hơn 1 bậc (khoảng 0.1 nm).

Để hiểu được thử thách của loài người khi xử lý những vật chất nhỏ cỡ này, hãy thử xem xét điều tương tự ở quy mô lớn hơn. Trạm Vũ trụ Quốc tế nằm ở vị trí 268 dặm (431 km) phía trên Trái đất. Nếu như con người là những người khổng lồ lớn đến độ đầu chúng ta với tới được trạm ISS, chúng ta sẽ lớn hơn mức hiện nay là 250,000 lần. Nếu như bạn phóng đại khoảng 1 – 100 nm của công nghệ nano gấp 250,00 lần, bạn sẽ đạt mức 0.25 mm – 2.5 cm. Vậy công nghệ nano tương đương với việc một người khổng lồ cao như trạm ISS gắng tìm cách dựng những đồ vật phức tạp một cách tỉ mỉ, sử dụng vật liệu nằm trong khoảng kích cỡ từ một hạt cát cho tới một nhãn cầu. Để đạt được tới ngưỡng tiếp theo – điều khiển những nguyên tử riêng biệt – người khổng lồ sẽ phải cẩn thận sắp đặt các vật thể cỡ 1/40 mm – nhỏ tới mức những người cỡ bình thường sẽ cần tới kính hiển vi để nhìn thấy chúng.

Công nghệ nano đã được thảo luận lần đầu tiên bởi Richard Feynman trong một bài nói chuyện năm 1959, khi ông giải thích rằng: “Nguyên lý của vật lý, theo những gì tôi được biết, không phủ định khả năng thao tác ở cấp phân tử. Theo lý thuyết thì một nhà vật lý có thể tổng hợp bất kỳ chất hóa học nào mà nhà hóa học viết ra… Bằng cách nào? Đặt những phân tử xuống những nơi mà nhà hóa học chỉ, và rồi bạn có thể tạo ra chất đó.” Đơn giản là như vậy thôi. Nếu như bạn có thể tìm ra cách di chuyển những phân tử hay nguyên tử riêng lẻ, bạn có thể tạo ra mọi thứ theo đúng nghĩa đen.

Công nghệ nano đã trở thành một lĩnh vực nghiêm túc lần đầu tiên vào năm 1986, khi kỹ sư Eric Drexler đặt nền móng cho nó bằng cuốn tài liệu hội thảo Kỹ thuật Tạo tác, nhưng Drexler cho rằng những người muốn hiểu biết nhiều hơn về những tư tưởng hiện đại nhất trong công nghệ nano nên đọc cuốn sách được xuất bản năm 2013 của ông, Sự dồi dào căn bản (Radical Abundance).

Ô xanh hơn về Chất nhờn xám (Gray Goo)

Chúng ta hiện nay đang ở một ghi chú bên trong một ghi chú. Thật thú vị quá đi mất!

Dù sao thì, tôi đưa bạn tới đây vì đây là một phần hết sức kém vui về kiến thức công nghệ nano mà tôi cần phải cho bạn biết. Trong một phiên bản cũ hơn của học thuyết công nghệ nano, một phương án được đề xuất cho dây chuyền nano bao gồm việc tạo ra hàng tỷ tỷ những robot nano (nanobot) cùng phối hợp để xây dựng thứ gì đó. Một cách để tạo ra những nanobot này sẽ là làm một chiếc có khả năng tự nhân đôi và rồi để quá trình đó biến một con thành hai con, rồi hai con đó biến thành bốn, bốn biến thành tám, và trong vòng khoảng 1 ngày, sẽ có khoảng vài tỷ tỷ con sẵn sàng vào vị trí. Đó là sức mạnh của tăng trưởng hàm mũ. Thông minh quá phải không?